|

||

咨询QQ: 杂志订阅 杂志订阅 编辑 编辑 网管 网管 培训班 培训班 市场部 市场部 发行部 发行部电话服务:  010-82024981 010-82024981 | ||

|

||

当前,各行业正在大力推进数字化转型,我国数字经济快速发展。截至2023年底,我国在用数据中心机架总规模超过810万标准机架,算力总规模达到230EFLOPS,位居世界第二。随着算力规模的扩大,数据中心耗电量也迅速增长。中国数据中心产业发展白皮书(2023年)显示,预计到2025年,全国数据中心用电量达到1.2×1011kWh,全国数据中心的二氧化碳排放总量预计将达到10000万吨,约占全国排放总量的1.23%。为落实“碳达峰、碳中和”,国家发布一系列政策推进数据中心节能降耗,PUE指标要求逐渐向1.3、1.25以下快速演进。同时,随着单芯片算力密度持续增加,风冷散热逐渐成为瓶颈,AI服务器等高功耗设备的出现也加剧了机柜空间剩余现象。在国家双碳政策要求和芯片算力密度持续增加的双向压力下,液冷技术引入变得愈发迫切。

一、液冷技术优势

相比传统风冷技术,液冷技术可以大幅提高散热效率和业务可靠度,并且环境适应好,可以减少土地占用。

1)降低设备能耗,助力节能减碳

数字经济时代,算力需求迅速增长,加之5G的广泛应用,带动信息基础设施蓬勃发展,数据中心用电和碳排放也随之大幅增长。借助液冷技术,数据中心PUE可以降至1.1~1.2左右,可有效降低能耗,减少碳排放。以100个20kW液冷机柜为例,PUE从1.45降低到1.15,每年用电可节省超过1×107kWh,电费节省超过700万元,减碳6000吨。同时,液冷环境下可以减少或去除风扇,进一步降低服务器能耗。

2)延长设备寿命,降低运维压力

按照芯片10℃法则,温度每提高10℃,元器件寿命约降低50%。使用液冷方式,可有效降低CPU结温10℃以上(结温是电子设备中半导体的实际工作温度),延长服务器使用寿命。相较传统风冷,浸没式液冷方式可以移除风扇,降低了噪音和灰尘影响,热故障率低。数据显示,浸没式液冷环境下硬盘故障率低于风冷约50%。服务器故障率的降低和寿命的延长,可有效提高业务运行稳定性,降低运维压力。

3)环境适应性好,机架装机率高

传统风冷机柜对环境要求高,受外部环境和温度影响较大,液冷机柜对环境要求低,在较大温差区域部署仍可获得较稳定PUE。液冷机柜装机密度高,是传统风冷机柜的约3~4倍,相同算力下节省机房面积约75%。液冷机房可免部署空调,减少冷水机组,节省机房空间。

二、液冷技术路线

风冷服务器使用空气作为换热介质,液冷服务器使用工质水或者氟化液等液体作为换热介质由于密度、比热容和导热系数的差异,相同流量的液体相比空气散热能力最高可提升3500倍。液冷高效的制冷方式可以大幅提高服务器装机密度,减少对机架和机房空间占用。

根据冷却液与发热源的接触方式,液冷技术可以分为非接触式液冷和接触式液冷两大类。

1)非接触式液冷

非接触式液冷主要指冷板式液冷,通过液体在冷板内流动带走发热元件(CPU/GPU/VRD/DIMM等)的热量,实现服务器部分元件的散热。冷板式液冷的液体不与发热源直接接触。

液体的比热容和导热系数好,制冷效率高,冷板式液冷相比传统风冷散热技术可实现60%~90%的能耗降低,数据中心PUE值能降至1.2左右。同时,冷板式液冷服务器采用传统机柜方式部署,当前机房配套和服务器改造难度和成本较小,但由于其只对服务器中的部分高发热元件采用液冷散热,服务器中仍需配置少量风扇,机房也需要配置空调等对服务器中的非液冷元件进行风冷散热。

热管式液冷也属于非接触式液冷,利用热管将CPU等发热元件的热量转移到服务器外,再通过循环水带走,主要使用水、氟利昂和醇类液体作为冷媒工质,目前应用少。

2)接触式液冷

接触式液冷的液体与发热源直接接触,根据服务器的部署方式和机柜的形态可以分为浸没式液冷和喷淋式液冷两种。

(1)浸没式液冷

浸没式液冷是将服务器完全浸没在冷却液中,服务器与冷却液直接接触,通过冷却液的循环流动或蒸发冷凝带走热量。冷却液多采用矿物油、硅油、氟化液等不导电、非腐蚀性液体。

浸没式液冷服务器的所有发热元件均通过液冷方式散热,可完全去除服务器中的散热风扇,机房也无需配置空调。相较于冷板式液冷,浸没式液冷换热能力更强,节能降噪效果更好,数据中心PUE值可降至1.1及以下。但浸没式液冷通常需要改为箱式部署,部署密度一般低于冷板式液冷,机房配套改造难度和成本也较大。同时,浸没式液冷服务器的存储仅支持SSD和氦气盘,光电转接头和线缆需密闭或防腐蚀定制。

根据冷却液在冷却子系统中是否发生相变,浸没式液冷可以分为单相浸没式液冷和相变浸没式液冷。单相浸没式液冷的液体不发生相变,通过温升带走热量,冷却液在整个冷却子系统的循环过程中都以液体形式存在;相变浸没式液冷的液体遇热发生气化带走热量,相变后的气态冷却液被浸没腔体子系统内的冷凝器冷却变成液体,液体受重力作用流回腔体,完成冷却系统循环。

(2)喷淋式液冷

喷淋式液冷的冷却液从服务器机箱顶部的喷淋模块滴下来,通过冷却液与散热器之间的接触进行对流换热,从而为服务器的所有发热元件降温,再通过服务器内的流道汇集至换热器将热量散发。冷却液多采用矿物油和氟化液等不导电、非腐蚀性液体。

与浸没式液冷相同,喷淋式液冷服务器也可完全去除服务器中的散热风扇,机房也无需配置空调,数据中心PUE可降至1.1左右。与浸没式液冷不同的是喷淋式液冷服务器多采用刀片式部署,需要对机柜和服务器机箱进行改造,且喷淋式液冷的液体及维护费用低,用液量少。

3)液冷技术对比

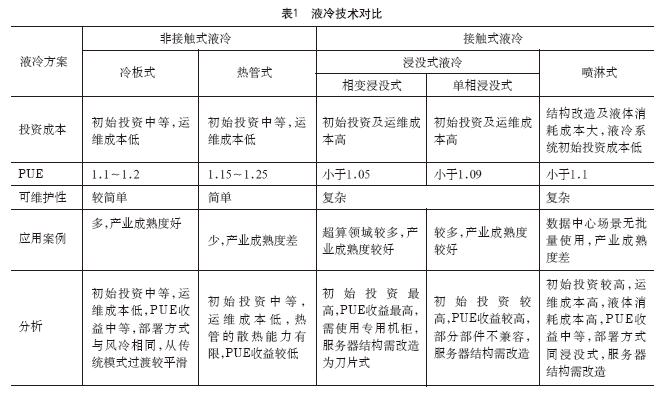

不同液冷技术的对比见表1。

综合考量初始投资成本、可维护性、PUE效果以及产业成熟度等因素,冷板式和单相浸没式相较其它液冷技术更有优势,是当前业界的主流解决方案,冷板式液冷可以实现从传统风冷模式的平滑过渡,在数据中心领域应用更多,本文后续主要基于冷板式液冷进行分析。

三、冷板式液冷主要部件

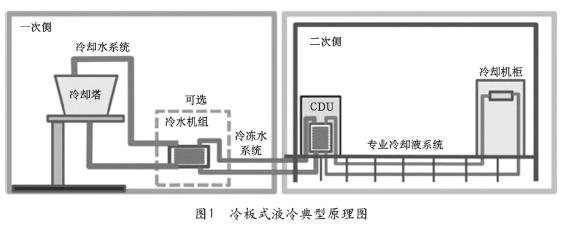

冷板式液冷的典型原理如图1所示。

冷板式液冷与IT设备紧密相关的部件集中在二次侧,主要包括冷却液、快接头和CDU等。

1)冷却液

冷却液目前业内选择有乙二醇溶液、丙二醇溶液和去离子水等。乙二醇溶液和丙二醇溶液为工业标品,可获取性高,乙二醇溶液成本相较于丙二醇溶液更低。去离子水具有良好传热性能,无毒安全,可作冷却液之一,但需要考虑0℃防冻问题。

冷却液均需要添加缓蚀剂和杀菌剂,防止管路滋生细菌导致堵塞和泄露,浓度建议在20%~30%。浓度不宜过高,过高会影响工质散热性能;也不宜过低,过低会影响防冻和抑制微生物滋生的能力。

2)快接头

快接头是液冷服务器中冷板模组和液冷机柜集分水器之间的水路连接接头。快接头分为手插快接头和盲插快接头两种形态。手插接头对运维人员要求较高,插拔操作依赖机房运维人员,服务器和机柜易于解耦。盲插快接头插拔具备自动化保障,操作方便,连接精度高,可满足未来自动巡检、机器人运维需求,但服务器和机柜解耦难度大。

快接头需支持插拔节点时快速连通和截断节点与液冷机柜集分水器之间的水路,保证不漏液,可免工具进行快接头的断开和接合,兼容不同冷却液,且流阻应尽可能低,降低液冷系统的能耗。

3)冷量分配单元(CDU)

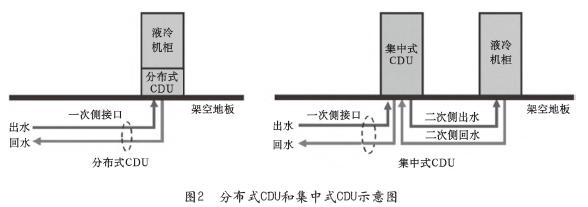

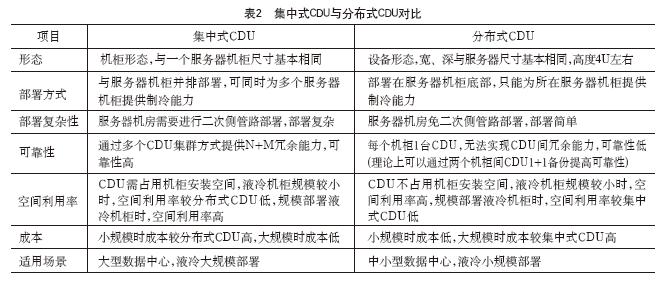

CDU是用于进行液冷服务器间冷却液分配的系统,提供二次侧流量分配、压力控制、物理隔离和防凝露等功能,也可针对一次侧和二次侧水质要求不同进行隔离。根据CDU的形态和部署位置,可分为集中式CDU和分布式CDU两种,如图2所示。

集中式CDU的单台CDU通常连接多个服务器机柜,可以同时为多个服务器机柜提供制冷能力,通过多台CDU集群实现N+M的冗余能力,可靠性高,适用于规模部署液冷服务器机柜的场景。分布式CDU免二次侧管路安装,单台CDU只为所在机柜服务器提供制冷能力,无法提供跨机柜的冗余能力,可靠性较集中式CDU低。集中式CDU和分布式CDU的对比见表2。

四、冷板式液冷服务器及机柜技术要求

1)服务器技术要求

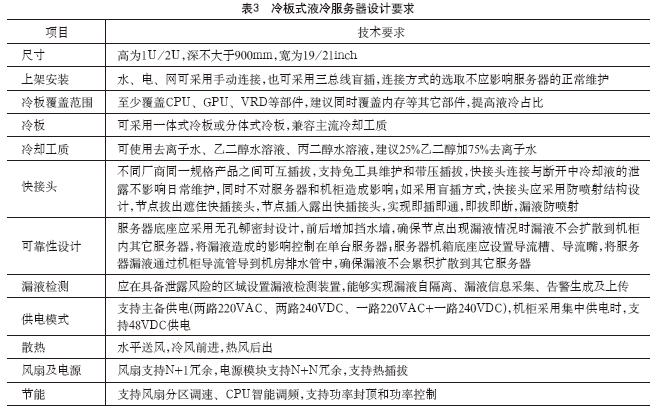

冷板式液冷服务器的设计需满足的技术要求见表3。

冷板式液冷服务器的设计除需满足表中的各种要求外,CPU、内存、硬盘和主板等还应满足传统风冷服务器的设计要求。

2)机柜技术要求

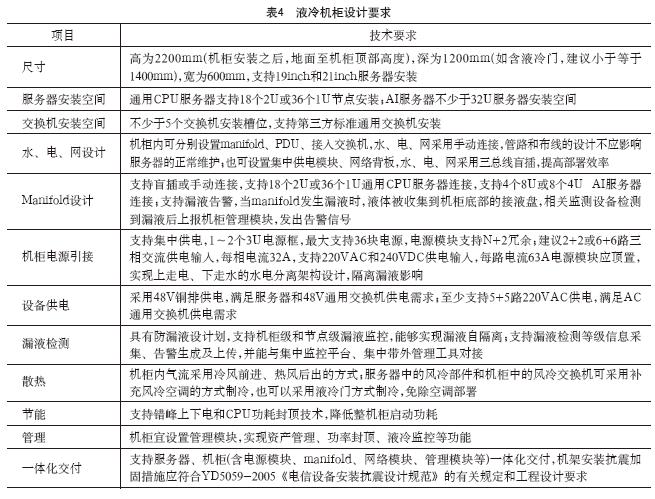

液冷场景下,服务器与机柜的耦合度较高,液冷机柜的设计需满足的技术要求见表4。

液冷机柜的设计除需满足上表中的各种要求外,运输安装、机柜内布线、功能分区等还应满足传统风冷机柜的设计要求。

五、数据中心引入液冷带来的变化

数据中心引入液冷服务器时,会对机房配套和运营维护带来变化,也会有不同的交付模式。

1)机房配套

数据中心引入液冷服务器时,部署密度增加,对机房承重提出更高要求。同时,静电地板高度、供电和维护空间等均有变化,机房配套变化见表5。

2)运维

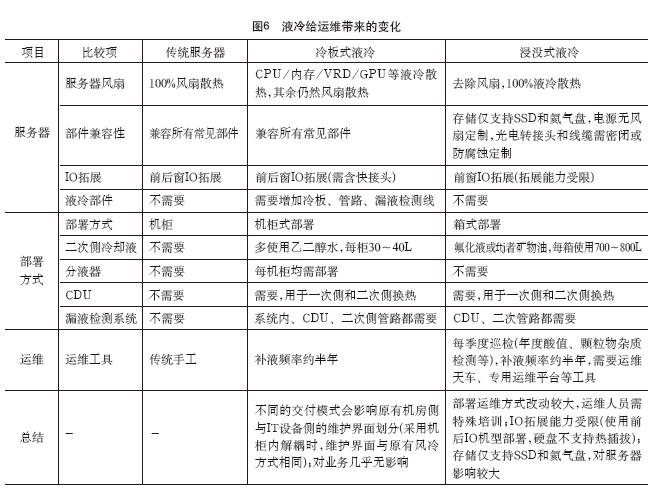

液冷服务器目前多为定制化部署,在部件兼容性、部署方式和运维工具等与传统风冷不同,具体见表6。

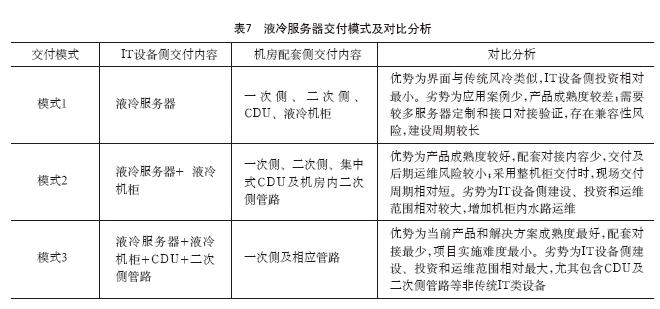

3)交付模式

数据中心液冷涉及一次侧散热系统、二次侧散热系统、CDU、液冷机柜、液冷服务器的对接,标准化程度较弱,各厂家之间缺少兼容性对接。根据交付内容不同,目前液冷服务器有3种交付模式,见表7。

数据中心引入液冷系统时应综合考虑产业成熟度、运维便利性、建设周期等因素。初期可以考虑模式二或模式三,积累建设和运维经验,后续逐步推进一次侧、二次侧、CDU、液冷机柜、液冷服务器的接口标准化,向模式一演进。

六、结束语

数据中心引入液冷服务器,可以显著降低机房PUE值,提高设备运行稳定性和业务可用性,增加服务器装机密度,减少机房土地占用,实现节能减碳。同时,不断提升的芯片功率密度和AI服务器等高功耗设备的逐步引入,也为液冷引入提供了更加广阔的空间,液冷逐步成为数据中心制冷的重要解决方案。

然而,液冷的标准化程度较低,不同厂家各自为战,尤其是液冷服务器和液冷机柜的耦合度很高,后续需要标准化相关接口,逐步实现水、电、网三总线盲插,使液冷不但好用,更要易用,充分发挥液冷在双碳中的作用。

编辑:Harris