|

||

咨询QQ: 杂志订阅 杂志订阅 编辑 编辑 网管 网管 培训班 培训班 市场部 市场部 发行部 发行部电话服务:  010-82024981 010-82024981 | ||

|

||

数据中心制冷的重要性不亚于供电,如果制冷失效,高温也会导致机器停机,使整个数据中心瘫痪。制冷的方式各种各样,效果也各有千秋,如何根据数据中心的实际情况选择制冷模式也是一个不可忽视的问题。

一、平面地板情况下的制冷

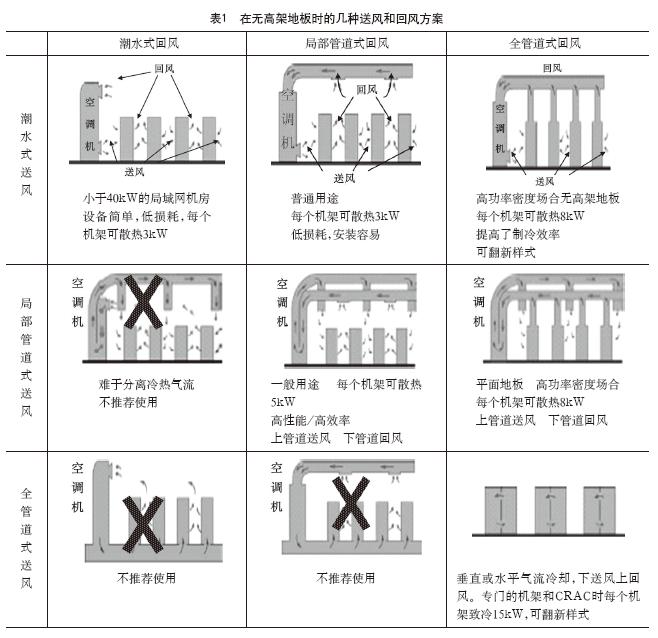

不论什么规模的数据中心都可以不采用高架地板。大多数LAN和网络机房就没有采用高架地板,很多现代数兆瓦级的数据中心也没有采用高架地板。那种传统的使用高架地板的理由在现代数据中心再也不存在了,因为发现使用高架地板有很多缺点,如需要专门的工程、专门的花费、需要设计时间、减小了机房的有效高度、增加了对地震的敏感度和危险性、降低了稳定度、地板要有一定的承重、增加了台阶或使通道倾斜及其他一些问题。由于这些原因,原建筑地板(硬地板)就成了首选的新结构方案。在一些较小的数据中心和网络机房,一般总是首选硬地板结构。表1就示出了在硬地板环境下的制冷系统解决方案。

在硬地板环境下,局部管道的送风情况取决于上方的管道系统和排放能力,如表1第2行的图示。在局部管道送风和局部管道回风联合使用时,就显得像表1那样有些复杂,但在使用中最为通用的方法是整个大楼采用集中空调;将送风管道安装在天花板上向下送风,而回风则是潮水式散流方式。

了解各种类型的制冷系统是合理使用它们的主要基础。尽管具体到个别环境是有所不同,但对使用某种类型的空调系统提供一个综合性的指导还是可能的。有的系统在规模上很大,功率密度非常高,它们的冷却就需要非常复杂的设计,而这种设计则主要是通风管道的设计。

为了使上述设计有效地接近要求条件,应该这样做:根据所要求的平均功率密度来设计一个制冷系统,但这个系统也必须可以满足高功率密度机柜所要求的冷却能力。高密度机柜的典型表现为仅仅是整个负载的一小部分,但它们在数据中心的确切位置是不可预知的。在这种情况下,在数据中心使用普通的高架地板设计恐怕对这种潜在的热点不能进行充分地冷却,而且已经导致了使用太大的制冷设备和气流分配系统,尽管付出了太大的超额花费,但仍然没有达到所希望的结果。管道输送冷却气流就提供了这样一种可能性,即它可以将冷却气流定点送到高热密度区,既实现了所要求的冷却愿望,又避免了冷却系统过大的花费。

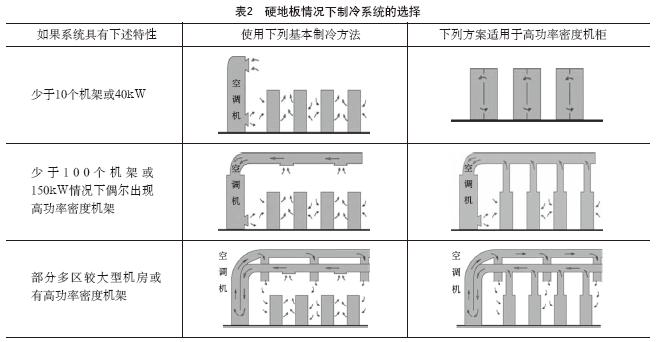

表2示出了在硬地板环境下如何选择正确的制冷系统。在更大规模和更高功率密度的情况下,就需要采取更为复杂的风道解决方案。对于每一种类型的系统而言都会提供一种方法,来应付那些超过平均机架功率密度的高功率密度机架。

由表2中可以看出,随着数据中心功率密度的增加,其制冷气流分配系统的复杂程度也越来越高,相应地使投资也相应地增加。

二、高架地板情况下的制冷

虽然硬地板设计方法是新机房结构的首选方案,但由于目前仍有不少系统还习惯用高架地板,而且在高架地板情况下有些解决方案还是行之有效的。比如在下列的情况下这些方法都可以使用。

1)有的机房在作为数据中心前就已经安装了高架地板。

2)有些大型计算机的地板下已经安装了通风口。

3)有很多水管贯穿数据中心。

需要注意的是,电源走线和数据布线不是安装高架地板的理由。按理说在任何情况下,都不应该在高架地板下敷设电源线和数据线,因为它会显著降低制冷系统的冷却效果。电源和数据线采用上走线的方式是高密度数据中心最好的方法。由于电源电缆和数据电缆在地板下阻断了预先设计的气流模式,由于挡住了气流的通路而强迫其改道。另外,由于在地板下需要电缆通路,所以需要经常性地由操作人员掀开地板块去增加或除去电缆,这就进一步中断了送入IT设备的气流。

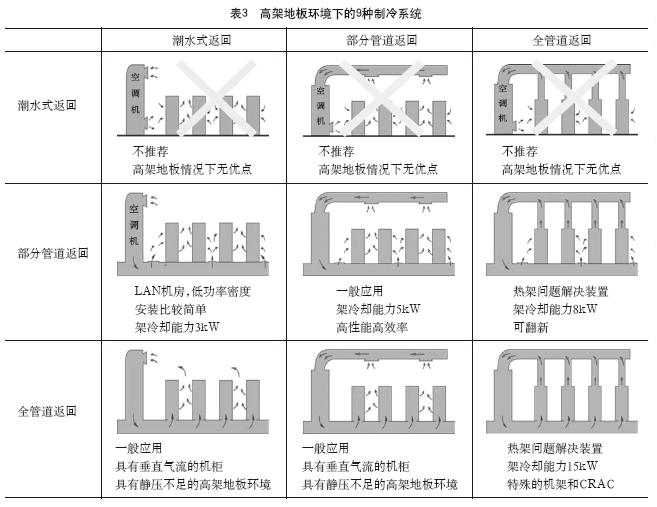

在高架地板环境下,局部管道送风是经由像表3中第2排所示的高架地板送风图来实现的。如果有高架地板存在,就可以使用部分管道送风,但使用潮水式散流送风并没有什么优点,所以也不应该予以考虑。所以表3中所给出的潮水式散流送风方式,在高架地板情况下是不被推荐使用。

上部回风管道的使用,加强了对靠近设备热风出口回风的吸力。全管道回风考虑了如何消除冷热气流混合的问题,因此也考虑了在机架(特别是在靠近机柜的顶部)处均匀一致的入口温度和对CRAC制冷效率的提高。此外,回风管在靠近数据中心热点处可以被调整到最大回风吸力。可以这样设计,把回风管格栅作为悬挂活动天花板的组成部分,于是就可以容易地知道那些需要的地方。

表3给出了9种用于高架地板环境的制冷系统。

在高架地板环境下选择正确的制冷方案:

了解各种类型的制冷系统是合理使用它们的主要基础。尽管具体到某一个个别环境是这样或那样的不同,但对使用某种类型的空调系统提供一个综合性的指导还是可能的。有的系统在规模上很大,功率密度非常高,它们的冷却就需要非常复杂的设计,而这种设计则主要是对更为复杂的通风管道的设计。

关键是要有一有效的设计方法,在这一点上和硬地板情况相同:根据所要求的平均功率密度来设计一个制冷系统,但这个系统也必须可以满足高功率密度机柜所要求的冷却能力。高密度机柜的典型表现为仅仅是整个负载的一小部分,但它们在数据中心的确切位置是不可预知的。

表4给出了在高架地板情况下如何正确的选择制冷系统。对于更大规模和更高密度情况而言就会导致更为复杂的管道解决方案,就每一个类型的系统来说就意味着要为几个高密度机架进行冷却,而这几个高密度机架的功耗明显超过了每个机架的平均值。

需要注意的的是,不论是高架地板或是平面地板情况下的制冷,从上面的所有方案都可以看出。数据中心机房内机柜的排列是分冷热通道的,为了优化制冷效果,机柜的排列一般是面对面和背对背。面对面的是冷通道,是冷风入口;背对背的通道是热通道,是排风和回风口。

以上讨论了在各种情况下的制冷方案选择,并了解到在全管道通风的条件下如果再加上特殊措施就可将对每个机柜的致冷量提高到15kW。那么近期数据中心的功耗情况是一个什么水平呢?表5给出了某可用性研究中心前几年对300家数据中心用电情况的调查表。由于数据中心发展很快,机柜的功率密度也在急速增长,数据中心内单机柜的实际最高功率超过20kW的例子。

三、制冷量的估算与设备选择

1.机房热量的来源

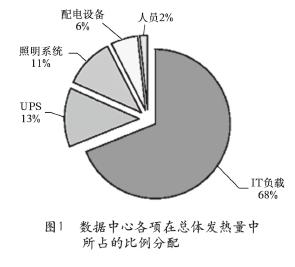

所有电子设备在工作中无一例外地都会产生热量。数据中心或网络机房内的IT设备产生热量,照明系统产生热量,供配电设备产生热量,工作人员产生热量,外部环境通过辐射、穿透、传导和对流等途径也向机房内传递热量。图1示出了一个典型的数据中心的热量分配关系。

由图1中可以看出,IT负载的发热量最大。这是因为一个数据中心机房中,IT是用电的最终负载,在这里将电能完全变成了热能,至于配电设备、UPS等只是输送电能的通道,功率的损失只是一些沿路损耗,所占比例较小。在这里没有考虑阳光因素间接传递过来的能量,所以只是一个大致的分配。这一些外界的和内部的热量就导致了机柜内温度的升高,根据阿累纽斯(Arrhenius)定律,一般电子元器件在25℃以上,每升高10℃,寿命就会减半。因此必须随时将这些热量消散,以避免设备温度上升到一个无法承受的高度。而且一般来说,这些热量是不会自然散失的。为此,一般数据中心等机房均采用了利用空调机进行强制散热和冷却方法。

2.数据中心机房的热量估算

系统的整体发热量为各个分系统发热量的总和。整个系统包括IT设备,以及UPS、配电设备、空调设备、照明设备和相关人员等。而幸运的是,这些项目的发热量可通过简单的标准规则轻松确定。比如UPS和配电系统的发热量由固定损耗和与运行功率成比例的损耗两部分组成。这些损耗在不同品牌和型号的设备间通常保持一致,因此可轻松估算出来,并且不会发生太大的偏差。照明设备和人员的发热量也可使用标准值估算出来。确定整个设备的冷却负载所需的唯一信息(如占地面积“平房英尺”和相关电气系统功率等)是固定可用的值。

空调设备会通过风扇和压缩机将这些热量排出到外部环境,从而不会在数据中心内部造成太大的不良影响。然而,它也会抵消一部分空调系统的功效,因此在确定空调功率大小时通常需要考虑此因素。

一方面我们可以使用发热量数据对数据中心的每一项目进行发热分析,同时也可以使用简单的规则快速估计出一个结果,这一结果通常在详细结果的准许偏差范围之内。快速估计的优势在于评估人员无需具备专业知识或接受专门的培训。

1)发热量的快速计算

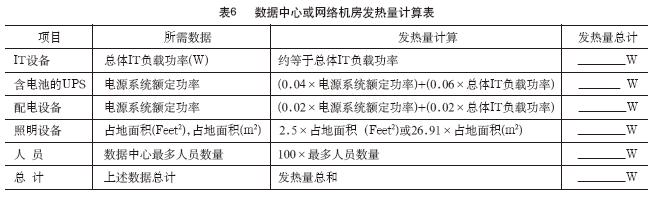

表6提供了一个可对发热量进行快速计算的工作表。借助该工作表,相关人员将可以快速可靠地计算出数据中心的整体发热量。

2)数据的定义

总体IT负载功率(W)等于所有IT设备的输入功率总和。

电源系统额定功率等于UPS系统的功率等级。如果使用了冗余系统,不要计算冗余UPS的容量。

3)典型系统实例

作为一个例子,此处介绍一个典型系统的发热量。在本例中,数据中心占地5000平方英尺,功率250kW,拥有150台机架,员工数量最多20名。在本例中,假定数据中心的容量达到30%,已往的机房通常是这个水平。在本例中数据中心的总体IT负载是250kW的30%,或大约80kW。在这种情况下,总体数据中心发热量为116kW,比IT负载高约一半。在本例中,数据中心内不同设备在总体发热量中所占的比例如图1所示。需要指出的是,UPS和配电设备的发热量比例有所扩大,这是因为系统的实际运行功率仅为额定值的30%。如果系统以100%的额定值运行,电源系统的效率将增加,在系统发热量中的比例也会相应提高。效率的一个重大损失就是系统余量过大所造成的实际成本。

编辑:Harris