|

||

咨询QQ: 杂志订阅 杂志订阅 编辑 编辑 网管 网管 培训班 培训班 市场部 市场部 发行部 发行部电话服务:  010-82024981 010-82024981 | ||

|

||

一、芯片发展带来的能耗与散热挑战

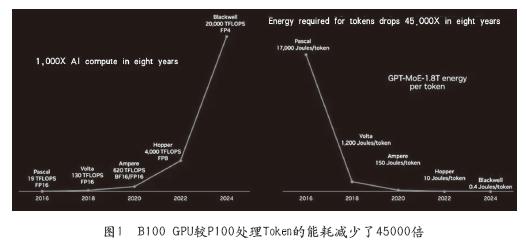

随着GPU等芯片的发展,基于大模型的人工智能产业得以快速迭代。以英伟达为例,从2016年推出Pascal系列GPU之后,基本保持了两年一代架构的GPU芯片智能算力的快速提升。随之而来的是在做人工智能大模型训练和微调时,模型进化所需要的能源在不断减小。如图1,是英伟达创始人黄仁勋在2024年GTC大会上公布的数据,从P100芯片到目前最先进的B100芯片,在训练GPT-MoE-1.8T这样的模型时,每token所消耗的能源下降了45,000倍。

按照这个数据我们来推演一下,训练一个GPT4-MOE-1.8T大模型,以10天为训练周期所需要的能源总数如表1所示。从所需电力总量的对比可见,芯片算力的进步是算力普惠的必由之路。足够便宜的算力成本,可以推动智算行业蓬勃发展,赋能千行百业。

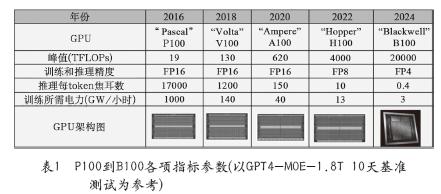

但芯片算力的快速发展,在部署时遇到了基础设施方面的瓶颈与挑战。随着算力的提升,芯片的TDP(散热功率)也在快速攀升,见图2所示。从英伟达V100到GB200的芯片散热功率的变化值,以及未来Rubin系列的功耗预测来看,芯片散热功率很快达到1600W以上,甚至更高。

按照英伟达最新的计划,采用最新芯片架构的GB200算力模组,模组的散热功率达到5400W,如此高的芯片功率密度,给GPU服务器的供电和散热等基础设施提出了新的挑战。

二、液冷技术应用的机遇与挑战

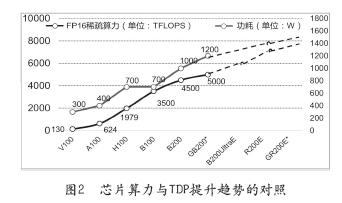

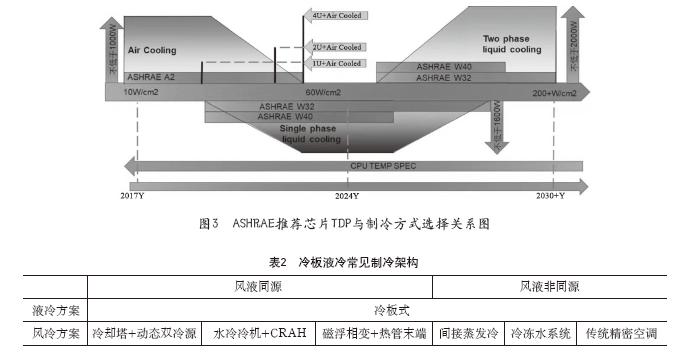

按ASHRAE(美国采暖、制冷与空调工程师学会)的推荐,当芯片的TDP大于300W以上、每平方厘米功率达到10W以上时推荐使用液冷制冷技术,详见图3所示。同时液冷的应用也可以大幅度降低PUE和WUE。因此智算的快速发展给液冷技术在数据中心的应用提供了前所未有的机会。

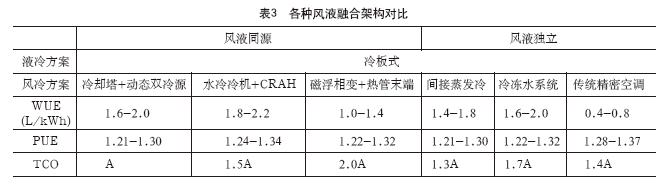

可以看出随着芯片和机柜热密度的提高,制冷技术会从风冷过渡到单相液冷再过渡到相变液冷,最后演变成全液冷方案。而制冷架构也从液风比较低的非同源高温自然冷液冷,逐步过渡到能够提供温度调节范围更宽的水冷机组全液冷架构。目前来看,以GPU芯片为主的智算数据中心,目前多采用冷板液冷技术进行设计与部署。我们也发现,冷板液冷是一种风液混合的制冷方式。因此在设计智算中心冷板液冷制冷架构时,我们要兼顾不同的风液技术的组合。考虑到液冷与风冷是否使用同一套外冷源,我们把冷板液冷系统分为风液同源和风液非同源两种,根据不同的同源关系以及风冷的制冷方式,我们把常见的冷板液冷架构进行了分类,详见表2所示。

不同的制冷架构可以获得不同的算力性能、能耗水平和全生命周期拥有成本。我们结合亚太区的实际应用环境做一个案例测算。

三、亚太地区智算中心发展遇到的气候挑战

亚太地区面积广阔,横跨多个气候带和海洋系统,因此气候特征呈现出多样性和复杂性:东南亚为典型的热带雨林气候和热带季风气候,这些地区全年高温多雨,降水丰富。

东南亚地区的数据中心众多且发展潜力巨大,本文以马来西亚为例,介绍亚太区气候特征及散热挑战。

根据OMDIA的研究报告,马来西亚数据中心最多的三个地区为:吉隆坡、赛城、新山。吉隆坡距赛城30多公里,距新山300多公里,但新山紧挨新加坡。因此选择吉隆坡的气候特征进行分析。

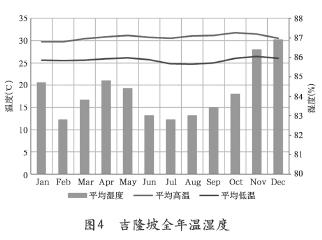

吉隆坡位于北纬3°08',东经101°42',马来西亚半岛的西海岸。吉隆坡为热带雨林气候,四季如夏,日照充足且降雨丰沛。年温差和日温差小,年平均温度在23-34℃之间,湿度介于70%到95%之间。1月是一年中最冷的月份,平均气温27℃左右。5月是一年中最热的月份,平均气温29℃左右,详见图4所示。

根据ASHRAE的气象数据,吉隆坡近10年的极端高温为36.9℃,极端低温为21.3℃,极端湿球31.3℃。

四、不同风液融合架构下WUE、PUE、TCO对比分析

测算的对比标准是:

地点为马来西亚吉隆坡;

一次侧供液温度35℃;

冷冻水系统使用水冷冷机,磁悬浮系统使用蒸发式冷凝器,风液独立架构中液冷部分使用冷却塔;

液冷占比为50%-85%。计算结果详见表3所示。

对比可知不同的制冷架构会获得不同的系统结果,分别表现在WUE、PUE和TCO方面。这类的横向比较会给用户在做架构设计时给出指引,客户可以根据自己的边界条件,选择最合理的制冷架构。

五、数据中心制冷技术的演进展望

随着以人工智能为代表的新技术越来越广泛的应用,推动了全球多个领域对于高密机柜的需求。无论是基础设施厂家、服务器厂家还是云服务商,都在积极开发新的冷却技术来支持机柜内更高的发热量。

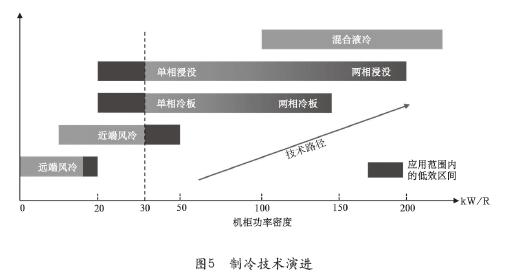

图5展示了随着机柜功率密度的增加制冷技术的演进方向。

从图5的技术路径可以发现,随着机柜热密度的提升,制冷技术的发展路径是不断地靠近服务器从而降低热阻。近端风冷靠近热源,散热效率高于远端风冷,可以解决50kW以内的热密度,但同时也带来能效低、噪音大等问题。因此,当热密度超过30kW/R时,建议优先考虑液冷方案。

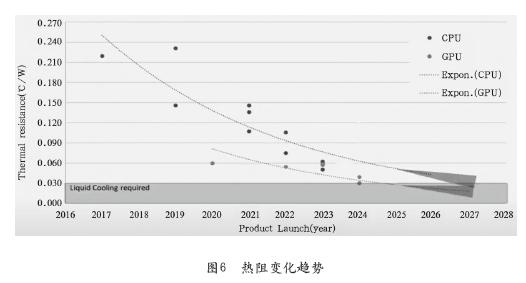

图6是OCP(开发计算项目)对于CPU&GPU热阻的趋势研究,可以总结两点:GPU是液冷技术迭代的主要驱动力;转型液冷之后,仍然需要不断地技术升级从而达到更低的热阻。

未来在数据中心液冷板块,主要的演进方向:更高效的散热方式、散热介质和散热系统设计;以及更低的接触热阻。前者的重点在于新型的散热系统的设计和热循环验证;后者的重点是新型导热材料的开发与验证。

作者简介

张迪,深知社AIDC首席研究员。哈尔滨工业大学电力电子专业硕士,在维谛技术工作18年,一直从事IDC产业相关工作,目前负责解决方案架构工作。

编辑:Harris