|

||

咨询QQ: 杂志订阅 杂志订阅 编辑 编辑 网管 网管 培训班 培训班 市场部 市场部 发行部 发行部电话服务:  010-82024981 010-82024981 | ||

|

||

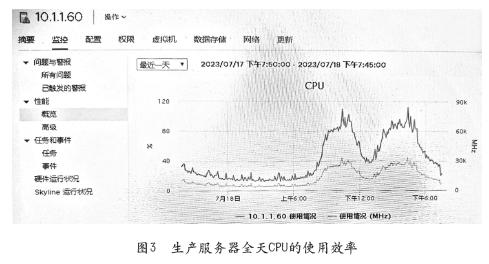

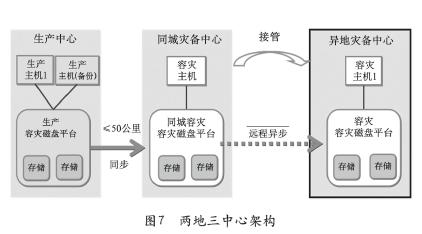

在应用系统开发中很少考虑服务器算力的综合利用,在一些企业当生产环境业务处理峰值超过服务器算力60%时,就开始进行扩容升级或购置更高算力的服务器。从安全的角度许多企业(如金融)主系统均采用了双机热备、同城和灾备环境,以两地三中心为例,需要生产、同城和异地三套系统,其同城和异地的环境利用率很低,见图7。

2)服务器的空转和闲置

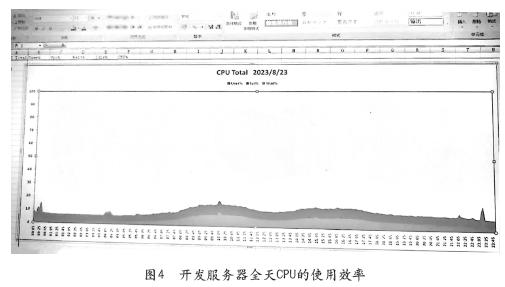

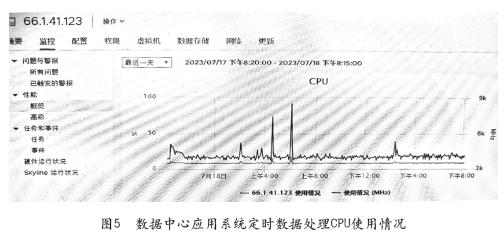

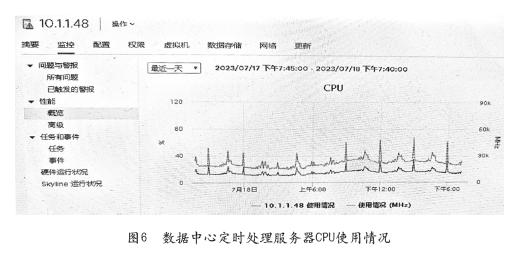

对于一些按时间段处理的系统(如周、月、季、年数据分析、统计报表等),大部分时间都在空转;对不是24小时对客户服务的系统(如开发、测试、培训等),每天有10小时处于空转状态,据不完全统计数据中心通常在晚间存在70%耗电空转的服务器;全年节假日超过60天,节假日同样也有超过70%的系统的服务器处于空转耗电状态;为此产生了大量的电力浪费。另一方面由于业务、开发和运维管理的分离,有些系统已经下线,但服务器仍然没有关电下架,长期处于空转的状态。

以一个1000台服务器数据中心,平均每台服务器300W的数据中心为例:

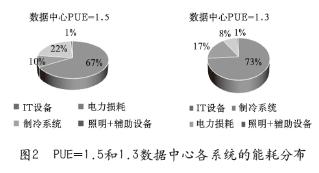

全年的耗能为:1000×300×24×365=2,628,000KWh。按PUE=1.3计算,全年耗能3,416,400KWh。基础设施耗能788,400KWh,占全年总耗能的23%。

然而晚间70%的空转服务器有700台,全年空转耗电为:700×300×10×365=766,500KWh,占IT全年耗能的29%,占全年耗能的22%。

全年节假日的天数按60天计算,70%的空转的服务器,全年的耗能为:700×300×24×60=302,400KWh,占IT全年耗能的11.5%,占全年耗能的8.9%。

可见空转和闲置的服务器浪费的耗能超过基础设施的耗能。对于智算和超算中心这类靠出租算力的外向型的算力中心,闲置率更高。

3)数据中心资源的孤岛

目前对于超算和智算中心是面向社会提供算力的资源和服务,而99%的数据中心还是传统的通用算力,每一个数据中心都是一个独立封闭的单位,即使集团内总部和分支机构的数据中心的服务器也未实现资源的共享。

针对数据中心算效低下的情况需要从以下几个方面提高数据中心算力的算效:

(1)随着虚拟技术和云技术的出现,通过对服务器的虚拟化,将数台服务器组成一个资源池,可以同时支持数十个系统的运行,比如对开发和测试等环境按照4:1的组合,不仅可以有效的减少服务器的投入,缓解了数据中心机柜增长的需求和时间,更重要的一点提升了算力的实际利用率,节省的电能的消耗。

(2)开启服务器的休眠技术,服务器的节能技术包括:动态节能、部件休眠等。动态节能技术是在智能监测系统状态基础上,对电源、处理器、风扇等组件运行状态进行调整,进而达到节能效果。服务器的部件休眠技术包括:CPUC-state休眠、硬盘休眠、电源模块休眠等部件休眠。处理器较长时间处于空闲状态时,根据休眠状态的设置,处理器将切断CPU的内部时钟或降低CPU电压来实现节能,单处理器深度休眠后的功耗可降低50%以上。

(3)从应用系统开发的角度系统的整合和复合利用,提高应用系统的有效算效。

(4)做好不同环境的整合和复用,比如开发和测试共用;灾备的系统兼生产系统的新系统上线前的验证、数据查询、测试、培训和演练等等。

(5)分时段关闭空转的IT设备,做好假日、晚间IT节能,减少IT设备的耗能。

4.采用AI的技术减少数据的采集,提高数据的利用率

大数据的到来,数据的量(Volume)以从PB跃升到EB级,数据的存储以磁盘阵列为主。

应该看到数据的种类有:数据、文字、视频、图片以及地理位置信息等等保罗万象,已无规律可循,但是大部分的数据实际使用的价值密度低,以视频为例,在连续不间断监控过程中,可能有用的数据也许只有一两秒。比如,街口“天网”监控;交通道口和高速公路的违法监控;银行等服务行业的面对客户服务全程录像,柜台进出现钞人民币冠字号的扫描;银行柜台传票和事后监督的扫描数据等等,每天都会产生海量图像数据。随着手机支付的普及,上亿的银行卡成为很少活动的卡或“死”卡等等。

在数据中心的基础设施中,目前一个3000个机柜的数据中心,需要1000个摄像头无死角监控,1080P高清,4M码流,90天存储周期需要4000T;采用6T的硬盘,需要8个磁盘阵列,每个阵列5KW,8台磁盘阵列40KW,全年耗能350,400KWh,然而这些数据几乎很少使用。因此需要科学合理的对数据进行分门别类的治理,尽可能减少大量的使用频度很低的数据占据长期占用存储容量,导致能耗的浪费。

1)数据的分层存储

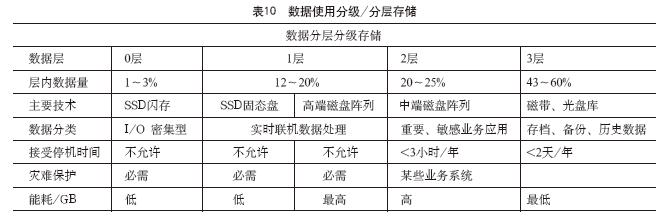

应该看到实际上数据中心的有60%以上的数据是可以做离线备份,减少在线存储设备堆积,减少存储的能耗,或者说同样的存储容量可以容纳更多的实际需要在线的处理数据。因此需要对数据进行分类和分层处理,一般按照数据使用频度,数据的存储可分为4层,具体的分层见表10。

实时处理的数据放在固态或高端存储中,周期性(数天)数据可以放在中端的磁盘阵列中,存档和不常用备份的数据可以采用离线的存储(磁带或光盘)。如果将60%的数据采用分层或离线的方式存储,可以减少50%在线存储设备的投入,大幅度减少磁盘阵列的耗能。

2)采用动态技术实施数据采集和管理

(1)比如1000个摄像头的数据中心,每天有人访问的时间很少,采用移动侦测技术,每天每个摄像头的记录时间可在2小时以内,有效的减少录制的时间和数据的存储量,原设计4000T,可减少到500T。

(2)采用AI人工智能的技术,对需要监控的场景进行动态的跟踪和分析,只记录有价值的数据。

(3)只对活动的卡、账户做处理,只对变更的数据做增量备份,可有效的节省存储的访问量和服务器的处理时间。

3)实施数据整合与挖掘,提高数据的共享和利用

建立企业级的数据仓库和数据湖,建立各类客户关系(CRM、ECF),收集各类数据进行归类和整合后集中存储、集中处理和集中管理、数据共享,减少数据的重复录入,提高数据的利用率。

五、结束语

综上分析与研究,数据中心的节能不仅仅只关注基础设施的能效,更需要研究算力与耗能、实际算效与耗能的关系,应该看到算力侧能耗严重浪费存在的问题,关注如何提高算效、减少对能源的消耗。数据中心的节能从“1”做起有很大的空间,而且都是成熟的技术,不需要投入(或少投入)就能实现和提升从算力侧的节能减排的效果,另一方面从运维管理的角度,科学做好算力的调度,充分发挥实际算效能力,科学的调节或关闭利用率不高以及闲置的服务器,有效降低IT的耗能。因此在双碳目标的推动下,数据中心的节能减排将从基础设施的节能向IT设备的节能转移势在必行,IT设备的节能减排将会成为节能的主战场。

作者简介

杨晓平(1953-),男,江苏扬州人,大学本科学历,原中国银行(上海)数据中心安全处处长,江苏银行信息科技部资深技术经理。中治研信息技术研究院高级研究员。毕业于解放军国防科技大学计算机专业。从事IT领域工作50年,在科研、石油数据处理、银行信息科技工作的经历,参加我国银河超级计算机研发,熟悉IT架构、规划、系统集成、信息安全、数据中心建设和运维,灾备、检测与认证。参与参加《数据中心设计规范》、《数据中心等级评定》、《数据中心运行维护管理标准》、等多个数据中心标国家和团体准编审。CDCC、CCDC、NIIS、GDCT、TGGC、DBRTA、ITRAA等协会和团体专家技术委员会的委员。

编辑:Harris