|

||

咨询QQ: 杂志订阅 杂志订阅 编辑 编辑 网管 网管 培训班 培训班 市场部 市场部 发行部 发行部电话服务:  010-82024981 010-82024981 | ||

|

||

引言

PUE是由美国绿色网格组织(TheGreenGrid,TGG)提出的评价数据中心能源效率指标,其含义是数据中心总耗电与IT设备耗电之比。由此可见,PUE是一个趋向于1的值,越接近,越能说明该数据中心电能利用率高。

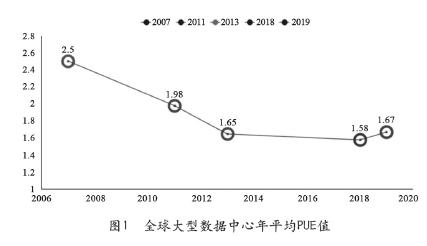

Uptime Institute2019年数据中心调查报告显示,全球范围内规模最大数据中心的年平均PUE值为1.67[1](2018年PUE平均值为1.58),调查对象来自世界各地的数据中心运营人员和IT管理人员,样本数量高达624个,如图1所示。此外,运营商、云计算服务商等对数据中心能效的极致追求,也使得其PUE值愈发亮眼。自2008年,谷歌公司首次公开PUE数据[2]以来,其所有数据中心的整体PUE值逐年降低,2019年谷歌公司所有数据中心的PUE平均(TTM:Trailingtwelvemonth)仅为1.10,已跻身全球能效最高的数据中心之列,如图2所示。

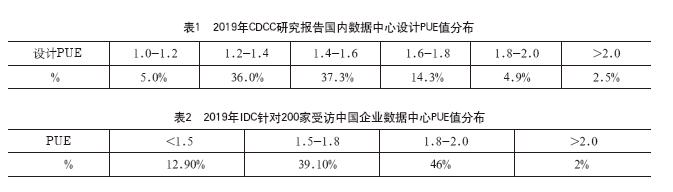

近年来,国内一线城市如北京、上海、深圳等数据中心集中地区的政府机构对数据中心采取限制政策,通过PUE的严格管控,推动数据中心向绿色、高效发展。2019年CDCC研究报告[3]显示,国内数据中心设计PUE主流值在1.2~1.6之间,占比约73.3%,PUE值>2.0以上的数据中心极少,且随着时间推移,逐步淘汰。数据中心设计PUE分布比例如表1所示。

对于投运的数据中心能效值,研究机构IDC发布的《2019中国企业绿色计算与可持续发展研究报告》显示,在调查的200多家国内大型企业中PUE值低于1.5的比例为12.9%,但依然有85%的受访企业数据中心PUE值在1.5~2.0之间,具体比例如表2所示。行业互联网公司百度2018年公开宣称,其阳泉云计算数据中心单模组年均PUE值为1.1。

综上,国内外投运的数据中心年均PUE值大多位于>1.5的水平,互联网公司数据中心全年平均PUE值往往较低,处于行业先进水平。虽然数据中心在设计阶段便充分考虑及应用先进技术手段降低PUE值,但项目实际投运后,基于IT负载率、运营管控等不同条件,数据中心实际年均PUE值与设计值存在较大差异。此外,数据中心的项目选址、电气与暖通技术架构配置、冷/热通道SLA(Service-Leve lAgreement,服务等级协议)、BA系统调优等诸多因素均会导致投运的数据中心年均PUE值千差万别。

本文旨在基于北京某第三方数据中心全年运行能耗数据,分析典型常规水冷架构数据中心的全年度PUE变化趋势。通过对比PUE与IT负载率、室外温湿度等因素的关联度,剖析解构前端冷源、末端气流等制冷系统各组件能耗占比,对典型常规水冷制冷系统能效优化,提出治理方向与借鉴。

1 某数据中心项目简介

(1)项目概况

本项目为既有厂房改造,坐落于北京亦庄经济开发区。该项目为某云服务商定制化数据中心,按国标A级标准进行设计建设,数据中心建筑面积约12000m2,钢筋混凝土框架结构。数据中心共规划1000架8kW机柜,并于2017年底投产运行。

(2)变配电、UPS系统简介

数据中心具备完整的高低压供电系统,能满足数据中心全部负荷的用电需求,该系统由10kV市电电源、0.4kV低压柴油发电机组、油机市电转换供电系统、高压配电系统、低压配电系统和UPS系统构成。由2个不同变电站引入4路10kV一类市电,采用2主2备形式,同时配备了采用N+1冗余的8台低压柴油发电机组组成低压供电输入端,并配置14套市电油机转换供电系统,保障市电中断情况下可自动切换。UPS系统采用了多种供电架构,其中普通IT机柜为“HVDC+市电直供”,核心IT机柜为“双UPS”的供电架构,UPS系统电池可支持系统满载15min,核心IT机柜可支持系统满载30min。

IT机房末端精密空调及冷冻水泵供电方式采用UPS+市电,末端一对一ATS切换;配电室、电池室精密空调及前端冷源系统的冷机、冷却水泵、冷塔等供电方式为双路市电。

(3)暖通系统简介

前端冷源配置4个制冷单元,N+1冗余,冷冻水供、回水温度为15℃/21℃,系统形式整体为一次泵+闭式蓄冷罐串联模式。每个制冷单元内含变频离心冷水机组、冷冻水泵、冷却水泵、开式横流冷却塔。冷源控制BA系统设置机械制冷、预冷、自然冷却三种运行模式。不间断制冷满足15min,冷却水补水蓄水不低于12h。

末端管道为环型供水管网布设,IT机房单侧房间级水冷精密空调制冷,核心区列间级水冷精密空调制冷,冷通道封闭(冷通道SLA:25℃),地板下送风。IT机房集中新风除湿,并配置独立湿膜加湿器。运营商接入间采用风冷精密空调,辅助区采用水冷精密空调。办公区设置水源热泵回收机组,水源侧接入冷冻水回水管路,冬季回收数据中心余热供应办公区、大堂风机盘管及柴发间散热器。

2 全年PUE变化趋势

数据中心PUE能耗统计以10kV进线侧高压计量柜录入数据中心总用电量,以IT侧列头柜为计量点录入IT设备用电,计算数据中心PUE。

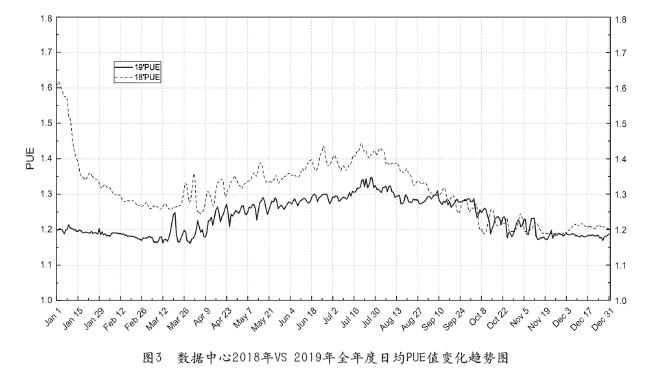

(1)2018年VS2019年全年度日均PUE值变化趋势图

项目自2017年底投运上线,2018年均PUE值为1.298,2019年均PUE值为1.236,见图3所示。2018年,伴随IT设备陆续上架,负载率上升,暖通、电气等基础设施设备进行了优化调整。此外,BA系统控制参数同步进行调优设置,数据中心能效治理制度与措施的落地与持续改进,使得2019年全年度PUE值取得较大提升,数据中心能效进入常态化治理。

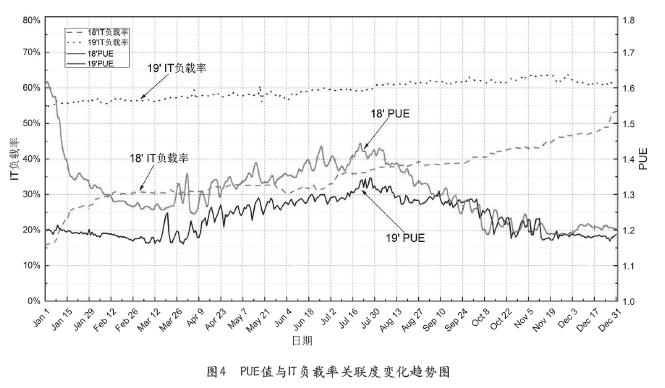

(2)PUE值与IT负载率关联度

图4为IT负载率与全年度日均PUE值对比变化趋势图。如图所示,对比2018年与2019年2月自然冷却模式运行期间,IT负载率从30%上升至56%,PUE值同比大幅度降低约0.06。同样,对比2018年与2019年3月-8月预冷、机械制冷模式运行期间,平均35%IT负载率条件下,其PUE值要明显高于IT负载率60%的情况。IT负载率超过40%以后,即对比2018年与2019年9月后的变化趋势,虽然2019年IT负载率已超过60%,预冷、自然冷却模式下其PUE值与2018年同期相比PUE值的差异已经不明显。限于IT设备上下架、业务属性、时间条件等因素,IT负载率未能提高至70%以上,故其对PUE变化的影响在此不予分析。

从两个完整全年度日均PUE值变化趋势来看,在IT负载率不高于40%时,同等条件下IT负载率高,PUE值越低。在IT负载率超过40%后,同等件下PUE值的差异不明显,即IT负载率不再是影响PUE值高低的关键因素。

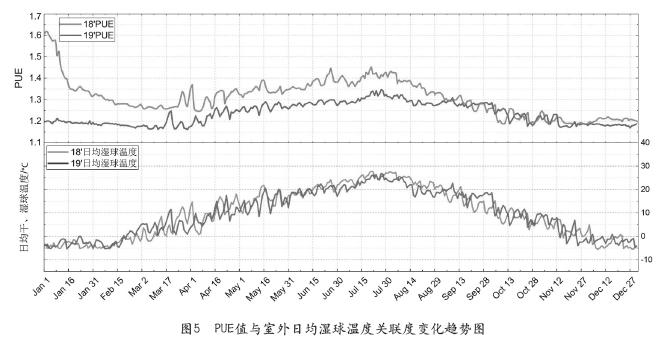

(3)PUE值与室外日均湿球温度关联度

图5为室外日均湿球温度与全年度日均PUE值对比变化趋势图。如图所示,室外日均湿球温度与PUE值呈正相关,其变化趋势基本一致。因制冷系统运行模式切换控制基点是基于室外湿球温度来实现的,从图中可以看出,每年三月中旬至五月初、九月底至十一月初,伴随室外湿球温度的剧烈波动,BA系统会选择性地运行自然冷却、预冷与机械制冷模式。在夏季运行机械制冷模式时,当室外湿球温度超过25℃时,日均PUE值会有明显的上升。

需要说明的是:在数据中心制冷系统实际运行过程中,虽然室外湿球温度达到设计工况点,但室外气象参数未来几个小时内变化趋势、BA系统模式切换判断条件延时设定、电动阀门在线/离线切换设定、主观运营管理方法等因素均导致各制冷模式运行时长与理论设计工况产生偏差。但可以肯定的是,合理运用预冷模式、尽可能延长自然冷却时间,对降低PUE值能产生积极影响。

统计本项目2018年自然冷却、预冷与机械制冷模式运行天数分别为:175、42、148天,2019年自然冷却、预冷与机械制冷模式运行天数分别为:146、45、174天。两个自然年度内预冷模式运行天数几乎一致,维持在40~45天的区间内。但自然冷却与机械制冷模式差异较大,究其原因应该是如下两个方面因素导致:

①IT负载率影响因素。因2018年IT负载率整体较低,制冷单元的制冷能力存在较大的富裕量,相应自然冷却向预冷模式、预冷向机械制冷切换的临界湿球温度点比设计工况略高,同样反向切换也类似;

②自然气象影响因素。每个年度自然气象不尽相同,2019年9月中旬至10月初运行机械制冷模式天数远超2018年同期。

3 PUE能耗分布与制冷组件占比分析

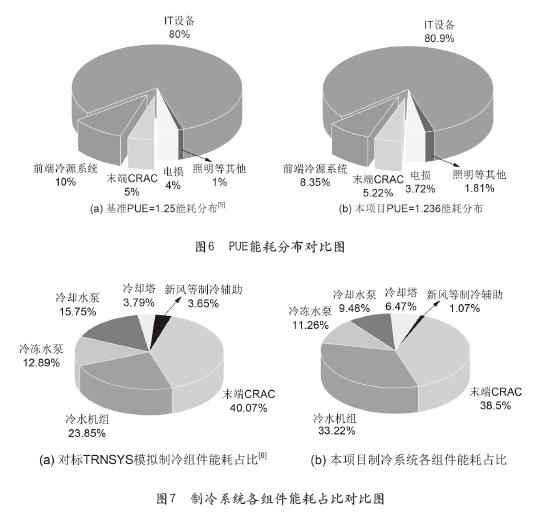

(1)PUE能耗分布

图6为PUE能耗分布对比图,图6(a)为基准PUE值为1.25的能耗分布[5],图6(b)为本项目2019年全年度能耗数据分布。如图所示,IT设备的基准能耗基本趋于一致,对于前端冷源系统则相对偏差较大,相对于基准值本项目冷源系统能耗要少16.5%,其他各项整体差异不大。由此可见,相较变配电系统的能效优化难、系统风险性高而言,制冷系统更具备优势,且冷源系统的能效优化弹性直接决定数据中心PUE值的高低。

(2)制冷系统各组件占比分析

图7为制冷系统各组件能耗占比对比图,图7(a)为徐龙云等[6]基于TRNSYS平台模拟的北京某数据中心水冷架构的制冷系统各组件能耗占比图,图7(b)为本项目2019年度制冷系统各组件能耗占比图。

从对比图中可以看出,冷水机组与末端精密空调占据制冷系统绝大部分能耗,本项目运营实践数据占比高达71.72%,TRNSYS模拟数据为63.92%。数据差异主要因冷水机组占比偏差较大导致,其原因无外乎模拟过程中冷水机组低负载、低冷却水进水温度下COP设定值与冷机实际运行功耗差异,以及模拟情况下自然冷却、预冷、机械制冷模式切换的理想化与实际运行时长的差异。末端精密空调占比约40%,TRNSYS模拟与实践结果显示差别不大。但需要指出的是,对于第三方数据中心因末端制冷更接近客户IT设备,运营时更期望其气流组织稳定、安全,不超越SLA限定。针对冷却侧能耗,TRNSYS模拟与实践结果有略微差异,在后续章节(制冷因子CLF解构分析)中会进一步说明。

4 制冷负载系数CLF解构分析

通常,PUE可简单划分为IT设备基准耗电比(该值为1)、制冷负载系数(CLF:Cooling LoadFactor)、供电负载系数(PLF:PowerLoadFactor)。CLF定义为数据中心中制冷设备耗电与IT设备耗电的比值;PLF定义为数据中心中供配电系统耗电与IT设备耗电的比值。

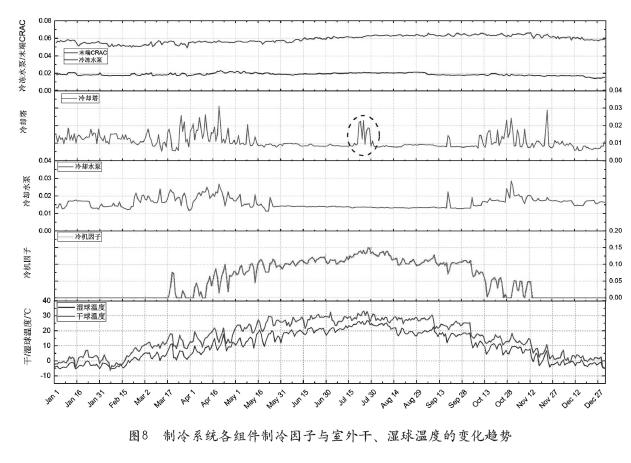

基于CLF的定义,取制冷系统各组件耗电与IT设备耗电比值,可进一步得到制冷系统中前端冷源的冷水机组、冷冻水泵、冷却水泵、冷却塔、末端精密空调的制冷因子。图8为2019年本项目制冷系统各组件制冷因子与室外干、湿球温度的变化趋势。

如图8所示,末端精密空调制冷因子全年维持在0.06水平,客观上仍有一定的优化空间,但因第三方数据中心实施偏保守控制策略,此部分能效优化需结合IT设备负载率、SLA、运营管理体系综合决策。受益于末端供回水压差控制策略,冷冻水泵制冷因子全年维持在0.02水平,无较大波幅。

本项目冷却侧为冷却塔、冷水机组一对一设计、非环网结构,冷却塔风机基于冷却塔出水温度实现其变频控制。从图8可以看出,冷却塔风机在预冷模式下其制冷因子相较于自然冷却、机械制冷模式要高。只有冷却水出水温度尽可能低,才能在板式换热器内对冷冻回水进行冷却,降低冷水机组负荷。此外,室外湿球温度超过25℃时,冷却塔风机频率增加比较明显。但冷却塔风机高频率运转所带来的能耗增加与冷却水温度降低导致的冷水机组能耗降低,两者如何取舍以达到叠加能耗最小才是能效治理的方向(假定冷却水泵已维持较低频率运转)。在本项目中,以冷水机组冷凝温度每降低1℃,机组COP提升3%考虑,在冷水机组制冷因子为0.15的条件下,冷却塔风机低频(30Hz)与工频运转导致的制冷因子差异约为0.02,风机能耗增加量约抵消冷凝温度降低5℃所带来的节能效果,即冷却塔出水温度不能降低5℃以上时对制冷系统能耗的影响为负面。当然这一结论需结合IT负载、冷水机组与冷塔配置功率、BA系统稳定性等因素灵活运用。

冷却水泵基于冷却侧供、回水温差实现变频逻辑。在预冷模式下,板式换热器与冷凝器均投入运行,水环路阻抗的增加自然导致冷却水泵制冷因子增加。在机械制冷模式下,采取锁频控制,维持较低频率运转。实践发现,与机械制冷相比预冷模式下PUE值能降低约0.02。

5 结束语

基于项目投运后两个年度的数据中心能耗数据,分析了PUE值与IT负载率、室外湿球温度的关联度。通过分析PUE能耗分布与制冷系统各组件占比,解构CLF各制冷因子,阐述了制冷系统各组件制冷因子变化趋势,分析结果如下:

①在IT负载率不高于40%时,同等条件下IT负载率高,PUE值越低。但IT负载率超过40%后,便不再是影响PUE值高低的关键因素;

②室外日均湿球温度与PUE值呈正相关,其变化趋势基本一致;

③冷水机组与末端精密空调占据制冷系统绝大部分能耗,本项目实践数据显示其占比高达71.72%;

④鉴于制冷系统中冷水机组、冷却水泵、冷却塔的全年变化幅度大,能效治理时应重点予以关注。

参考文献

[1]Andy Lawrence.Is PUE actually going UP? [EB/OL].https://journal.uptimeinstitute.com/is-pue-actually-going-up/, 2019-05

[2]Luiz André Barroso, Urs Hölzle, and Parthasarathy Ranganathan.The Datacenter as a Computer:DesigningWarehouse-Scale Machines,Third Edition[M].Morgan &Claypool,2018:100-101

[3]CDCC.中日数据中心市场报告[R]. 2019:23-24

[4]叶睿琪,张素芳.绿色云端2020-中国互联网云服务企业可再生能源表现排行榜[R]. 2020-01:16

[5]姚贇.高可靠性绿色数据中心的构建[M].西安:西北工业大学出版社,2013:347-349

[6]徐龙云,吴晓辉.基于TRNSYS的数据中心空调能耗及PUE分析[J].智能建筑,2020-01:61-66

作者简介

陈聪,国网思极紫光(青岛)云数科技有限公司跨专业综合工程师,注册公用设备工程师(暖通空调)。从事数据中心规划设计、建设、运营管理工作。聚焦暖通架构设计,能耗治理等。

彭广香,长期从事通信和数据中心行业,致力于数字基础设施供电新技术新架构的研究和应用,熟悉节能减排和储能技术等领域;是国内336V直流供电技术的开创者和倡导者,积极倡导标准化机房楼设计、模块化机房设计,先后主持或参与编制了二十几项国家标准、行业标准和企业标准。

编辑:Harris