文中介绍了Tirias研究公司正在进行的课程,课题预测了到2028年,生成式AI数据中心服务器基础设施和运营成本将超过760亿美元,生成式AI的成本和规模将要求在优化神经网络方面进行创新,并有可能将计算负荷从数据中心推到PC和智能手机等客户端设备上。

生成式AI已经变得越来越令人着迷,人工智能视乎有无限的潜力,但是人工智能在数据处理性能和能耗方面都有很高的要求,势必会带来成本的迅速增长。文中介绍了Tirias研究公司正在进行的课程,课题预测了到2028年,生成式AI数据中心服务器基础设施和运营成本将超过760亿美元,生成式AI的成本和规模将要求在优化神经网络方面进行创新,并有可能将计算负荷从数据中心推到PC和智能手机等客户端设备上。

随着生成式AI(GenAI)的大型语言模型(LLMs)的推出,世界已经变的既令人迷恋又令人关注人工智能的潜力。进行对话、通过测试、开发研究论文或编写软件代码的能力是人工智能的巨大壮举,但它们只是生成式AI在未来几年能够完成的任务的开始。所有这些创新的能力在数据处理性能和能耗方面都有很高的成本。因此,虽然人工智能的潜力可能是无限的,但处理器性能和成本可能是最终受限因素。

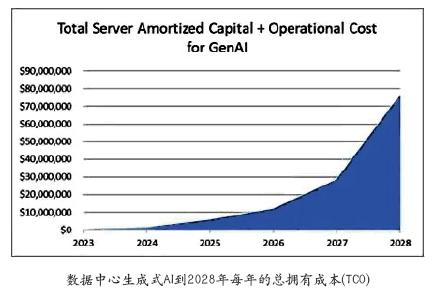

Tirias Research公司预测,在当前的进程中,到2028年,生成式AI数据中心服务器基础设施和运营成本将超过760亿美元,随着经济增长,将挑战紧急服务的商业模式和盈利能力,例如搜索、内容创建及生成式AI的业务自动化等。从这个角度来看,这一成本是亚马逊云服务AWS估计的年运营成本的两倍多。根据TiriasResearch公司的估计,AWS目前拥有云基础设施服务市场的三分之一份额。该预测包含了硬件计算性能显著提升4倍,但这一收益已经无法覆盖增加的成本,因为即使在推理算法及其效率方面的快速创新速度下,处理工作负载却增加了50倍。设计用于大规模运行的神经网络(NNs)将更加高度优化,并将随着时间的推移继续改进,这将增加每个服务器的容量。然而,这种改进被不断增加的使用、更苛刻的用例和具有参数更多数量级的更复杂的模型来抵消。生成式AI的成本和规模将要求在优化神经网络方面进行创新,并有可能将计算负荷从数据中心推到PC和智能手机等客户端设备上。

今天,绝大多数神经网络推断是在由图形或张量处理单元(GPU或TPU)加速的服务器上执行的,这些处理单元旨在执行矩阵计算的并行数学运算。每个加速器对每个“节点”(类似于是一个神经元)施加数千个系数“参数”(其类似物是一个突触)。网络按层排列,其中每一层由数千个节点组成,每个节点与前一层和后一层中的节点有数千个连接。在大型语言模型中,这些节点最终会映射到标记,或生成式AI突破数据中心:预计到2028年,数据中心基础设施和运营成本将增加至超过760亿美元深知社编译2024年5月总第3期11www.dc-se.com观察与分析数智元文本语言对象和符号。然后,先前生成的标记的历史——如提示和随后生成的响应——被用来分配概率,并从最有可能的下一个令牌中选择一个。

下一波像GPT-4这样的大型语言模型正在大量数据集上进行训练,目标是创建估计超过1万亿个参数的神经网络。如今,一个模型必须经常跨多个加速器和多个服务器运行,才能执行一个训练有素的大型语言模型,这将迅速提高成本。即使是包含数十或数千亿参数的更小的模型,也很容易超过强大的、基于云的GPU或TPU加速器的内存容量和性能要求,这些加速器具有大量的内存来有效地运行算法。

为了预测生成式AI的运营成本,Tirias Research公司在各种硬件配置上应用了复杂数据中心工作负载的预测总运营成本(FTCO)模型。FTCO模型结合了技术的进步、最终用户需求的变化,以及诸如媒体流媒体、云游戏和机器学习(ML)等工作负载的变化。就生成式AI而言,这意味着考虑到处理的进步,在可预见的未来,这将继续由GPU加速器技术驱动;训练神经网络模型的数据集和参数数量呈指数增长;模型优化的改进;以及对生成式AI永不满足的需求。首先,让我们来解决用户的需求问题。今天,生成式AI被用于生成文本、软件代码和图像,以及包括视频、声音和3D动画等新兴应用程序。在未来,这些基础能力将为日益复杂的生成式AI应用程序提供动力,包括生成视频娱乐、创建元版本、教学,甚至为城市、工业和商业应用程序生成流程。如今,开放式人工智能的ChatGPT的月客流量迅速接近20亿,而广受欢迎的生成式AI艺术社区“Midjourney”拥有超过1500万用户。为了预测需求,TiriasResearch研究公司分析了三种基本生成式AI的功能——文本、图像和视频——并将新兴市场细分为广告驱动的消费者、付费订阅用户和自动任务。对于文本生成式AI,类似于文字或符号的代币需求预计到2023年底将超过10万亿,有超过4亿的月活跃用户集中在发达市场。该预测估计,到2028年底,用户将超过60亿,约占智能手机市场普及率的90%,年代币将超过10亿,或增长100倍。图像生成式AI,预计将显著增加400倍超过10万亿图像,由于视频的出现,这将需要生产序列的主题和视觉连接图像使用更复杂的图像生成工具和复杂的提示循环。

其次,让我们解决计算工作负载。随着前所未有的学术和商业知识注入机器学习(ML)和生成式AI领域,生成式AI模型的效率正在提高。生成式AI图像和标记的质量因不同的片段、分辨率和模型大小等因素而变化,付费使用分配给更高质量的输出和相应的更高的数据中心计算资源利用率。预计的工作负载将把要求较高的大型模型与更高效、计算优化、更小的神经网络相结合。“由于更复杂的神经网络训练的更高效的神经网络的出现,将是推动生成式AI实现更可行的经济和更低的环境影响的几个力量之一。”TiriasResearch公司的高级分析师、FTCO模型的开发人员西蒙•索洛特科说。大规模参数网络将被用于快速训练较小的网络,能够更经济地运行,并在包括个人电脑、智能手机、车辆和移动XR等分布式平台上运行。HuggingFace最近展示了两个新的经过训练的类似ChatGPT的大型语言模型,300亿参数vicuna-30B和130亿参数vicuna-13B,使用Facebook的LLaMA大型语言模型框架,使用ChatGPT用户日志训练的大型语言模型框架。这种聪明的技术产生了一个类似于ChatGPT的大型语言模型,它可以在单一的消费设备上运行,其响应与训练它的更大的模型没有什么不同。高度优化,甚至更简单、更专业的模型,有望通过减少云中的模型规模,以及云中的工作量完全挤出来,使生成式AI应用程序能够分发到智能手机和个人电脑上,从而大规模降低数据中心成本。

ChatGPT3.5和vicuna13B的AI响应的比较

Tirias Research公司预测,2028年数据中心的电力消耗接近4250MW,比2023年增加212倍,服务器摊销成本加上今天的运营成本超过760亿美元。该成本不包括数据中心建筑结构的成本,但包括劳动力、电力、制冷、辅助设备和3年摊销的服务器成本。FTCO模型是基于服务器基准测试,使用10个NvidiaGPU加速器,峰值功率略超过3000W,平均利用率为50%,运行功率仅在峰值的60%以上。索洛特科先生继续说“使用数据中心创新者Krambu提供的高密度10台GPU服务器,Tirias Research公司能够对多个开源生成式AI模型进行基准测试,以推导出未来更高参数模型的计算需求。”该预测包括对未来五年的GPU和TPU加速器路线图的洞察,并使用这些路线图来计算每个服务器在每个用例中可以完成的工作负载——文本、图像和视频。也许FTCO模型最大的见解是存在一种平衡——随着工作负载变得更加复杂,服务器性能提高了约4倍,每个标志或映像的服务器吞吐量逐年保持相对稳定。

数据中心生成式AI到2028年每年的总拥有成本(TCO)

随着对生成式AI的需求继续呈指数级增长,摩尔定律的放缓,加工或芯片设计方面的突破似乎是长期的赌注。没有免费的午餐——消费者将要求更好的生成式AI产量,这将抵消效率和性能的提高。随着消费者使用量的增加,成本将不可避免地会增加。索洛特科总结道:“我们才刚刚开始理解机器学习的数据中心经济学。通过对整个需求、处理和成本的周期进行建模,我们可以发现最终什么将使工作量和经济向有利的方向转移。将计算转移到边缘,并将其分发给个人电脑、智能手机和XR设备等客户,是降低资本和运营成本的关键途径。”

五年前,在年度热芯片半导体技术大会上,各公司开始对数据中心电力消耗发出警报,他们预测全球计算需求可能在十年内超过全球总发电量。这是在生成式AI迅速被采用之前,它有可能以更快的速度增长计算需求。技术增强本身并不能克服采用生成式AI所代表的处理挑战。它将需要更改处理的执行方式,在准确性不显著影响的情况下对模型优化进行显著改进,以及建立新的业务模型,以支付仍然需要在云中处理的成本。这些点将会出现在生成式AI打破数据中心的第二部分中:移动生成式AI到边缘。

更多深度文章,请关注深知社公众号。

编辑:Harris

文中介绍了Tirias研究公司正在进行的课程,课题预测了到2028年,生成式AI数据中心服务器基础设施和运营成本将超过760亿美元,生成式AI的成本和规模将要求在优化神经网络方面进行创新,并有可能将计算负荷从数据中心推到PC和智能手机等客户端设备上。

杂志订阅

杂志订阅 编辑

编辑 网管

网管 培训班

培训班 市场部

市场部 发行部

发行部 010-82024981

010-82024981