本文全面剖析了数据中心需求缺口形成的多维原因,包括AI算力需求激增、基础设施供应滞后及传统数据中心选址受限等,为行业现状提供了清晰的全景图。同时,对热管理技术有所探讨,尽管DTC技术定义存在小误,但不影响整体阅读。此外,文章还详细分析了产业链各环节的市场机会,为相关企业提供了宝贵的发展思路。

译者说:首先,文章很好地阐述了数据中心需求缺口形成的原因。从AI算力需求暴增、基础设施供应滞后、到传统数据中心选址受限等多个维度,系统性地分析了当前行业面临的挑战。特别是对超大规模企业、主机托管服务商等不同参与者的角色分析,为想要了解行业现状的人提供了清晰的全景图。非常适合想要了解智算行业的读者阅读。其次,从热管理技术的角度,文章对散热技术的演进路径分析基本到位,但在Direct-to-chip(DTC)技术的定义上译者认为有误。真正的DTC技术应该是将冷却液直接通入芯片的substrate(芯片半导体层)中,实现DIE内部的冷却,而不是文中描述的简单冷板贴合方案。不过本错误不影响全文阅读。

最后,文章详细分析了从设备制造、系统集成到运营服务等各环节的市场机会,为产业链上的企业提供了有价值的发展思路。无论是传统数据中心服务商,还是新兴的技术供应商,都能从中找到自身定位和发展方向。适合推广阅读。

引言

面向人工智能的数据中心需求快速增长,为整个价值链上的企业和投资者带来了诸多机遇。企业和投资者如何快速把握这些机遇,有可能影响到全世界人工智能部署的进程。

人工智能时代新竞争已经开始——从容量和能力上,建设足够的数据中心,以满足人工智能不断加速增长的需求。在过去,大数据已经在现代生活中扮演了重要角色,数据中心的需求一度大幅攀升。而生成式人工智能(GenAI)的出现,将进一步推高这一需求,甚至我们将面临合适数据中心的供应短缺。

这既是挑战,也是机遇——如果能够深刻理解人工智能时代数据中心的设计要求,整个数据中心价值链上的企业和投资者都有机会参与解决这一迫在眉睫的容量危机。根据麦肯锡的中增速情景数据预测,未来新增的数据中心需求中的70%,是为了托管高级人工智能工作和智算。智算工作的新特性正在迅速改变数据中心的选址、设计和运营方式。

一、需求激增与供应滞后

影响未来数据中心容量需求的因素复杂多样,难以准确预测。其中,智算场景的普及速度无疑是关键因素,而智算芯片类型、组合及其功耗、智算工作中云计算与边缘计算的平衡,以及智算所需的基本计算、存储和网络需求也同样重要。

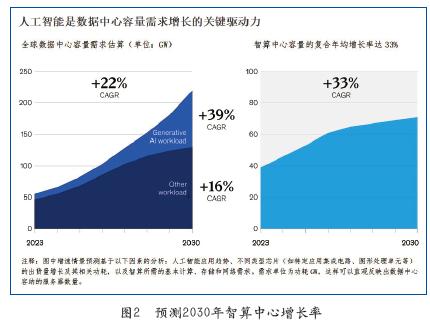

这解释了麦肯锡对于智算中心的预测数据。根据它对当前趋势的分析,从2023年到2030年,全球数据中心容量需求很可能以每年19%至22%的速度增长,最终升至每年171至219GW的需求。麦肯锡也给出了另一种可能性较小的高增速情景预测:需求增长率可能达到27%,总需求量攀升至298GW(如图1所示)。当前数据中心的年需求量为60GW,预测数据表明未来有很大风险出现数据中心容量供应的大缺口。若要避免这一缺口,我们要用1/4的时间,交付出2000年以来所建数据中心总和的两倍容量。

准确估算这一供应缺口的规模很难,因为需求增长的过程中有太多不可预知性:比如技术创新可能提升能源效率,而且数据中心业主和运营商长期扩张计划我们所知甚少。但是,就现在美国已知的数据中心建设计划推算,即使它们都能按时完成,到2030年预计将出现超过15GW的数据中心供应缺口。

造成这一潜在缺口的核心原因是,智算专用的数据中心,其容量和能力的需求独特——智算工作需要更高的计算能力和功率密度。根据我们的分析,在中增速情景下,2023年至2030年间,智算专用数据中心(智算中心)的需求预计将以年均33%的速度增长。这意味着,到2030年,大约70%的数据中心总需求将用于高级智算工作。其中,生成式人工智能(GenAI)作为当前增长最快的高级智算应用场景,将占总需求的约40%(见图2)。

二、容量的需求和供应被超大规模企业主导

像亚马逊AWS、谷歌云、微软Azure和百度这样的云服务提供商(CSPs),是当前智算中心新增需求的主要推动力量。因为这些超大规模企业,需要大量数据中心来运行它们内部开发的基础智算大模型(例如谷歌的Gemini),或通过数据中心托管业务运行由人工智能公司开发的智算模型(例如OpenAI的ChatGPT)。

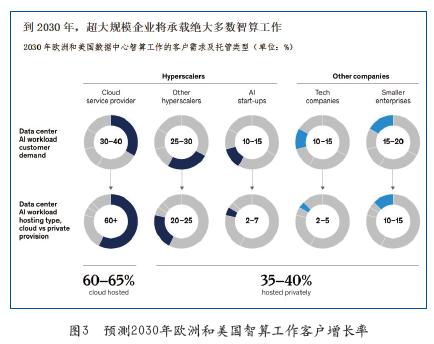

大多数其他公司则使用(或者优化)现成的智算模型,这些智算模型主要托管在公共云上。随着技术的逐步成熟,更多企业可能会基于自身内部数据构建并训练专属自己的AI智算模型,从而带来对托管私有化的需求。据我们估计,到2030年,欧洲和美国约60%至65%的智算工作将托管在云服务提供商的基础设施或其他超大规模企业的基础设施上(见图3)。

据麦肯锡估算,云服务提供商们,目前拥有全球超过一半智算中心。然而为了应对日益增长的需求,它们依旧在加紧建设最先进的设施和数据中心。由于供应限制的压力日益增加,这些云服务提供商也开始与主机托管服务提供商(俗称“Colos”)合作,而后者同样正在扩展其基础设施。

与此同时,一小部分图形处理单元(GPU)云服务提供商也正在涌现,以满足智算中心的需求。这些GPU云服务提供商,将高性能GPU的算力作为服务提供给客户,用于训练人工智能模型。它们通常与主机托管服务提供商合作,共同建设和运营数据中心。例如,GPU云服务提供商CoreWeave截至2024年7月已拥有约45,000台GPU,并计划到年底在全球28个地点开展运营。

然而,即使新增数据中心不断上线,仍难以赶上快速增长的需求。市场上供应紧张的情况已十分明显。在美国过去(2014年到2020年),主要市场中主机托管服务提供商的数据中心的租赁价格,呈稳步下降趋势;但从2020年至2023年间平均上涨了35%。此外,未来两到三年内计划上线的新数据中心也已全部被预订。北弗吉尼亚,由于数据中心高度集中,被称为“世界数据之都”。2024年,它的数据中心的空置率都已低于1%。更为严峻的是,对新数据中心的需求太过旺盛,进一步导致电力、关键电气基础设施和劳动力的供应短缺,这加剧了新设施的建设进度的延误。

三、数据中心新选址、设计和运营需求

过去十年间,数据中心经历了持续的变革与优化,规模逐渐扩大,容纳了更多高功耗、高密度的服务器,同时在运营效率和可持续性方面也有显著提升。

人工智能正在加速这一进程。最显著的是,数据中心在能耗规模上的快速增长。十年前,一个30MW(MW)的数据中心已经被视为大型设施。而如今,一个200MW的设施则被认为是常态。推动这一变化的核心因素是智算工作对计算能力的需求,这种需求又显著提高了能源消耗。

所有数据中心都需要消耗大量能源,但智算中心尤其苛刻,这主要是因为其机架内服务器的高平均功率密度。仅在两年间,平均功率密度已从每机架8kW(kW)翻倍至17kW,预计到2027年,随着人工智能工作负载的增加,这一数值可能攀升至每机架30kW。像ChatGPT这样的训练模型,其功耗可能超过每机架80kW,而英伟达最新的GB200芯片及其服务器组合,可能需要高达每机架120kW的密度。

如此高的能耗需求与功率密度,再加上不同智算工作负载的复杂性,使得数据中心建设在三个主要领域发生快速变革:选址及对应的配套电力基础设施、机械系统设计以及电气系统设计。

四、数据中心选址与电力基础设施

随着越来越多的数据中心建设以及其电力需求的增长,电力供应正成为传统数据中心选址的一个关键问题。例如,美国的北弗吉尼亚和圣克拉拉等地区,它们的公用事业系统无法足够快地扩建输电基础设施,这引发了未来可能会缺电的担忧。

供电问题可能会导致数据中心的扩张减缓。例如,一些公用事业系统在初期仅向数据中心提供较小规模的电力供应,随后随着电力基础设施的建设逐步增加供应——例如为一个100MW的新数据中心园区分阶段提供15至25MW的电力。此外,在一些国家,出于对数据中心对电网压力的担忧以及其对国家气候目标影响的考虑,已经完全停止了新数据中心的建设。例如,爱尔兰已暂停向都柏林地区的数据中心发放新的电网接入许可,禁令持续到2028年。根据爱尔兰输电系统运营商的估计,到2031年,数据中心将占该国总电力消耗的28%。

好在并非所有智算工作负载的电力需求都是一样的,这可以一定程度上缓解电力问题。在过去,低延迟一直是决定数据中心选址的关键因素之一,所以主机托管服务提供商会尽量在靠近人口中心的地方建立设施。然而,在训练人工智能模型时,低延迟和网络冗余的重要性有所降低,只有当模型投入实际运行(即推理阶段)时,这些因素才变得至关重要。因此,专门用于训练人工智能模型的数据中心正在美国的偏远地区建设,例如印第安纳州、爱荷华州和怀俄明州,这些地方的电力供应相对充足,电网压力较小(见图4)。然而,由于这些地区缺乏完善的输电基础设施,随着需求增长,电力供应问题可能仍然会出现。

在这样的背景下,一些数据中心运营商开始收购靠近电厂的设施,以解决输电问题(例如,由核电厂供电的Talen Energy数据中心)。此外,还有一些运营商已经开始通过“离网解决方案”,例如自发电,使用燃料电池、电池或可再生能源等方式实现离网供电。从长远来看,小型模块化反应堆(SMRs)可能成为一种选择。

五、机械系统(热管理系统)设计

人工智能服务器的能耗极高,因而会产生大量热量,以至于传统的风冷系统(通过在服务器周围循环冷空气)往往难以应对。通常认为风冷的有效上限是每机架功率密度50kW,这一水平可能适合功率密度较低的人工智能推理工作,但不足以支持训练工作负载。

因此,数据中心逐渐转向一种更高效的冷却方式,即通过液体直接从机架中带走热量(液冷技术)。液体在吸收和传导热量方面显著优于空气。目前有三种基于机架的液冷技术,它们在应用场景和对传统数据中心冷却系统的改动程度上有所不同:

1)后门风墙(Rear-doorheatexchangers,RDHX):

RDHX是最接近传统冷却技术的一种方式,它依旧对机架送入冷空气,用于强制风冷,但是产生冷空气的冷源是集成安装在机架背后的液冷热交换器。RDHX通常应用于空间有限且机架功率密度在40至60kW范围内的数据中心。

2)直接芯片冷却技术(Direct-to-chip,DTC):

DTC技术通过让液体(通常是防冻冷却剂或水与乙二醇的混合物)在冷板中循环,冷板直接与高功率密度电子组件(如GPU和某些CPU)接触,由内部循环流动的液体将热量带走。在这三种技术中,DTC技术是迄今为止应用最广泛的一种,因为它可以处理60至120kW的功率密度,并且相对容易与现有数据中心基础设施集成。

3)液体浸没式冷却(Liquidimmersion cooling):

这种方法是将服务器放置在充满介电液体的箱体中。液体浸没冷却分为两种:单相浸没和两相浸没。两者都可以冷却功率密度为100kW的机架,而两相浸没冷却已用于功率密度高达150kW的机架。液体浸没式冷却在数据中心中的应用推广较慢,主要局限于加密货币挖矿等更愿意尝试新技术的应用场景。此外,人们还对两相冷却中使用的含氟化学物质(PFAS)的健康和环境影响表示担忧。

液冷系统的另一个重要优势是,它能够通过直接冷却最热的部位,使电子设备保持更一致的温度。这不仅可以延长硬件的使用寿命,还能使其超频运行。此外,由于电子组件的热量直接被液体带走,液冷系统可以降低资本和运营成本,同时优化数据中心的能源使用效率(PUE)。一些数据中心的数据显示,通过采用液冷系统替代风冷系统,PUE降低了约10%。

六、电气系统设计

智算工作负载需要更大的配电单元以应对更高的功率密度,这促使许多数据中心运营商安装更大的开关设备和落地式的配电单元。这种做法简化了系统的复杂性,同时降低了安装和维护多个小型配电单元的资本和运营成本。

在机架级别,运营商也在重新考虑电力架构。由于人工智能芯片的功耗不断增加,一些超大规模企业和原始设备制造商(OEMs)正在考虑采用48伏电源单元的服务器,而非传统的12伏单元。通过减少能量损失和提升系统效率,这种设计在测试中已显示出至少25%的能量损失减少。人工智能的高能耗工作负载还需要更大容量的集中式不间断电源(UPS)系统,这使得电气系统设计更加复杂。

备用供电系统也在随之改变。以AI为主的数据中心正在重新评估其备用电源需求。传统数据中心通常运行关键业务应用程序,因此会配备备用发电机以应对任何可能的停电中断。然而,由于训练工作负载对业务运营的关键性较低,这类数据中心可以选择较低冗余的电力备份系统来满足需求。

七、机遇无限

通过深入了解AI数据中心的需求,我们可以清晰地看到这个快速增长的市场所带来的机遇。以下是几类主要机遇:

1)数据中心的所有者和运营商:主机托管服务提供商可以对现有数据中心进行改造,并建设更多新设施,特别是为超大规模企业提供容量租赁服务——即使这些企业已经在增加投资,仍可能难以满足需求。能够提供“按需定制”开发服务的主机托管服务提供商,即能够根据每家超大规模企业的具体需求和设计定制建设并运营数据中心的服务商,可能会成为极具吸引力的合作伙伴。此外,GPU云服务提供商也迎来了发展机会,其商业模式正受到投资者(例如英伟达)的青睐。此前英伟达主要将GPU销售给超大规模企业,现在他们正逐步扩大客户群,引入更多的GPU云服务提供商。

2)数据中心建设公司和设备供应商:由于供应紧张,模块化建设的需求正在增加。模块化建设不仅能更快地建成数据中心,还能使建设过程更加环保和可持续。同时,数据中心对各种机械和电气设备的需求也在快速增长。据麦肯锡估算,到2030年,用于采购和安装数据中心机械及电气系统的资本支出可能会超过2500亿美元。

3)能源和电力供应链领域:在能源和电力供应的整个产业链上,许多相关企业都有望从智算中心的建设浪潮中获益。这包括三类企业:一是专注于能源(尤其是绿色能源)生产和配送的企业;二是提供包括燃料电池、太阳能和小型模块化反应堆等现场可持续能源解决方案的企业;三是致力于将数据中心余热用于民用住宅或商业建筑的企业。

对于希望抓住这些机遇的企业和投资者来说,要在人工智能时代中胜出,可能需要调整传统的策略。以下是一些可行的方案:

1)行动更快:考虑到行业变化的速度,企业必须比以往更快速地行动。例如,数据中心的所有者和运营商需要迅速寻找并锁定具有可靠电力供应的新站点;冷却系统制造商需要创新,提供能够应对快速增加的功率密度的解决方案;而变压器等其他设备供应商需要扩大产能,以满足市场需求。

2)加强协作:持续创新是当今数据中心价值链的核心特征,企业需要加强彼此之间以及跨行业的合作。价值链中的公司之间或与其他领域企业的协作,能够加速创新步伐并实现规模化发展。例如,公用事业系统与超大规模企业或主机托管服务提供商之间的协作,有助于协调电网投资计划和数据中心容量扩张;芯片和服务器制造商与液冷解决方案提供商的协作,则能够设计并推广高效、易操作的冷却系统。

3)加大投资:数据中心基础设施以空前的速度扩展需要大量资本投入。据估算,这一生态系统将需要超过1万亿美元的投资。尽管全球范围内已有大量投资基金支持该行业的发展,但更多的增长机会依旧存在。许多公司已经开始采取行动。例如,黑石集团(Blackstone)和数字地产信托(Digital Realty)在2023年达成一项70亿美元的协议,计划在法兰克福、巴黎和北弗吉尼亚建设新的智算中心。美国服务器制造商超微电脑(SuperMicro Computer)正在本土市场和亚洲投资新站点,而科技公司HCL科技(HCL Technologies)则与施耐德电气(Schneider Electric)合作,在亚太地区开发管理数据中心能耗的解决方案。

此外,这些机会不仅限于大型企业。某些大型公司已经积压了大量订单,例如,某些原始设备制造商(OEMs)在定制电气开关设备和配电设备方面的交付周期已达一到两年。因此,较小或新兴的制造商有机会填补这一空白,特别是在投资者愿意支持其扩大生产规模的情况下。

编辑:Harris

本文全面剖析了数据中心需求缺口形成的多维原因,包括AI算力需求激增、基础设施供应滞后及传统数据中心选址受限等,为行业现状提供了清晰的全景图。同时,对热管理技术有所探讨,尽管DTC技术定义存在小误,但不影响整体阅读。此外,文章还详细分析了产业链各环节的市场机会,为相关企业提供了宝贵的发展思路。

杂志订阅

杂志订阅 编辑

编辑 网管

网管 培训班

培训班 市场部

市场部 发行部

发行部 010-82024981

010-82024981