|

||

咨询QQ: 杂志订阅 杂志订阅 编辑 编辑 网管 网管 培训班 培训班 市场部 市场部 发行部 发行部电话服务:  010-82024981 010-82024981 | ||

|

||

一、引言

近年来,全球人工智能大模型技术正进入跨越式发展阶段。Transformer架构驱动的深度神经网络在自然语言理解、视觉生成等核心任务中表现卓越,其模型参数规模已从千亿级突破至万亿级,并向更大体量演进。这一趋势对底层智算基础设施提出了多维度挑战。基于千卡级设备的计算架构在并行计算效率、网络通信性能及能耗控制方面,逐渐显现出体系性局限。在此背景下,新一代智能计算基础设施——万卡级异构加速集群(简称“万卡集群”)正成为新型算力基础设施的必然选择。该体系通过集成数万颗高性能加速单元(CPU、GPU、NPU、TPU、FPGA、ASIC等),构建具备超高带宽互连能力的通信网络,结合分布式并行存储架构及智能编排管理系统,形成面向复杂计算场景的异构融合计算环境。

本文通过系统分析方法,对当前智算中心万卡集群的发展现状、典型技术架构及其未来演进趋势进行解构,同时探讨其在实际部署与运行过程中所面临的关键技术挑战与解决方案,为相关领域的研究者与工程实践者提供参考。

二、建设布局现状

1.国际建设现状

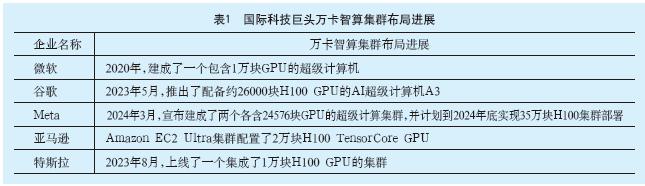

据公开新闻报道,国际科技巨头已成功构建了超万卡级别的智能计算集群,并正朝着百万卡规模迈进,如表1。这些进展体现了全球范围内对高效能计算资源的迫切需求及其在推动人工智能领域发展中的关键作用。

当前全球高端人工智能芯片市场,呈现出显著的技术垄断格局,其中NVIDIA依托其CUDA并行计算架构形成的技术壁垒,在全球人工智能芯片市场的占有率已飙升至90%。这样的产业格局直接影响了国际领先科技企业的技术路线选择,在已投运的万卡级智算集群中,多以NVIDIA的H100GPU为核心算力单元,并通过NVLink高速互连架构与CUDA-X计算框架深度整合。

2.国内建设现状

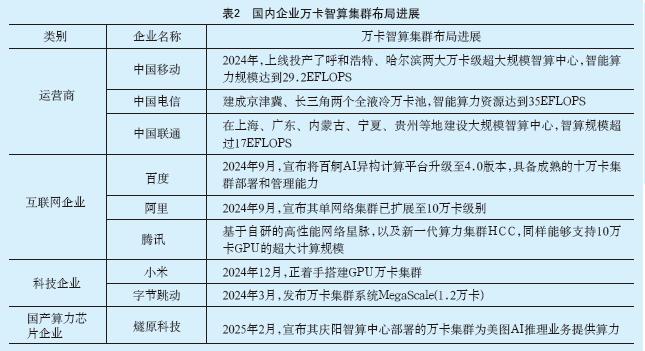

2025年3月,工业和信息化部新闻发布,截至2024年底,我国算力总规模达280EFLOPS(FP32),其中智能算力规模达90EFLOPS(FP32),占比达32%[1]。

据公开新闻报道,国内主要电信运营商、领先的互联网企业、科技企业、国产算力芯片企业等已启动或完成了万卡级智能计算集群的部署,如表2。

我国头部企业持续加码超大规模集群,集中力量实现训练性能突破;百度、腾讯等企业开发了面向超大集群的自动切分、任务容错系统;液冷、浸没式等新型冷却技术成为数据中心标配;一些平台已实现“国产+进口”GPU、NPU、ASIC的调度统一[2]。

国产技术仍需进一步突破大规模组网效率、网络隔离与负载均衡能力、软件生态成熟度、软硬件协同优化等瓶颈[3]。

三、技术架构现状

智算中心万卡集群作为支撑千亿级参数大模型训练与高并发AI推理的核心算力基础设施,其技术架构的复杂性主要体现在硬件、软件和网络三大模块的深度耦合与协同优化上。

1.硬件基础设施:异构计算与高密度集成

在硬件层面,加速卡集群的计算单元架构设计、网络拓扑结构以及供电与散热系统的优化对集群性能至关重要。

1)计算单元架构

智算集群架构按硬件配置可分为两类:通用加速架构(纯GPU集群)、混合异构架构(GPU+国产芯片混合异构集群)。这两类的技术差异,主要体现在算力协同机制、生态适配性及场景适用度等三个方面。通用架构侧重硬件性能的极致释放与开发生态的普适兼容,而混合架构通过跨国技术融合与自主定制实现了技术主权保障与场景特异性优化,成为国内智算中心的主流选择。

通用加速架构:典型配置采用NVIDIA H100/H200或AMD MI300X作为基础算力单元,单机整机可集成8、16颗加速芯片,俗称8卡机、16卡机。硬件层面采用NV Link4.0,实现节点内总带宽900GB/s全互联,支持FP8/FP16混合精度运算加速。网络层面部署Quantum-2 InfiniBand或800G RoCEv2协议,构建Dragonfly拓扑。存储体系,整合本地NVMeSSD(32TB/盘)与分布式全闪存,支撑EB级数据吞吐。

混合异构架构:集成NVIDIA A100/H100与国产华为昇腾910B、寒武纪思元590等加速单元,前者负责模型主干训练,后者负责卷积算子、注意力机制等特定计算任务专用优化。互联采用双级架构:芯片级PCIe5.0/CXL2.0互连,集群级部署华为HCCN或阿里Solar-RDMA协议。

以上两种架构对比分析如表3,展示了两种架构在适用场景、技术生态等方面的差异。

2)网络拓扑结构

智算中心万卡集群的网络设计旨在实现数万张高性能加速卡之间的高效互联。

主流的网络拓扑结构有3种。Fat-Tree/CLOS架构通过多层交换实现近似无阻塞通信,但扩展成本随规模呈平方增长。Dragonfly架构的网络直径低至3跳,适合延迟敏感型任务,但对负载均衡要求严苛。Torus架构的规则拓扑扩展性强,但网络直径随规模增大。

当前智算中心实际部署以分层CLOS与Dragonfly为主。光互连增强型CLOS(如NVIDIA Quantum-2 InfiniBand)正成为智算中心新趋势。混合拓扑(如Spine层用Dragonfly、Leaf层用Fat-Tree)开始应用于十万卡级集群。

3)供电与散热系统

供电与散热系统通常采用高压直流配电(HVDC)与液冷散热协同方案。供电架构普遍采用2N冗余设计,集成模块化UPS与市电直供模式。散热系统按设备功率密度差异分级部署,主计算区域采用冷板式液冷,高密度区域采用浸没式液冷。

2.软件平台:全栈智能化调度与优化

软件生态包含三个关键层:分布式计算框架采用PyTorch FSDP与Tensor FlowD Tensor支撑多级并行;存储层通过Ceph与GlusterFS混合架构储存管理EB级数据;资源调度器运用MOEA/D算法优化负载分配。

1)分布式训练框架

分布式训练框架通过通信库优化与混合并行策略提升性能,主流深度学习框架集成NCCL/HCCL构建超大规模训练系统。针对万亿参数模型的瓶颈,采用数据并行、模型并行、流水线并行、专家并行等并行范式进行优化。

2)资源编排系统

双层联邦调度架构实现全局资源优化。底层采用改进型Kubernetes调度器支持拓扑感知的任务分配,上层联邦调度器引入资源竞价机制。核心创新包括:基于强化学习的弹性伸缩模块、智能故障迁移引擎、能效优化策略。

3)AI原生中间件

AI原生中间件通过数据-计算协同优化与MLIR编译自动化降低系统复杂性。MLIR编译器实现多级中间表示转换,内存管理器通过动态分页技术将显存利用率提升。

3.通信网络:超低时延与无损传输

传统智算网络面临网络拥塞、延迟过高等问题,严重制约了大模型训练的效率和算力效能的释放,倒逼主流企业持续对网络架构进行创新。字节Megascale集群通过三层CLOS架构,支撑超万卡GPU互联。阿里采用双平面架构HPN7网络,支持多轨传输。腾讯星脉2.0采用三级Fat-Tree架构,拓展至10万卡级。Meta基于OCP开放生态构建三级网络,实现数万个计算节点扩展。

这些方案体现出智算网络的技术演进共性:协议栈重构(RDMA/GPUDirect优化)、可编程数据平面(P4/智能网卡卸载)、软硬协同优化(拥塞控制算法+拓扑感知路由)。

万卡级集群的网络架构通过拓扑感知路由与跨域互联技术,构建低时延、高吞吐的通信基座,支撑千亿级模型训练。

1)协议栈创新

网络传输技术方面,采用分层式增强型RDMA协议架构,集成RoCEv2与动态量化拥塞通知(DCQCN)机制,RoCEv2构建高速数据通道,DCQCN通过毫秒级流量感知与动态限速,在百万级并发请求中实现零丢包。

硬件卸载技术方面,智能网卡内嵌的ASIC引擎,将传输层协议栈及AllReduce通信负载从CPU剥离,降低主机通信开销。

2)拓扑感知路由

智能路由系统可在某条光链路出现微秒级拥塞征兆时,负载感知算法立即启动动态避障,从而降低热点链路流量峰值,避免设备过载损耗。

在数据聚合层,SHARP协议赋予网络设备“先思考后传输”的能力,通过交换机层级式聚合梯度数据,梯度同步不再需要逐级传输,减少网络传输次数。

3)跨集群互联

长距光传输技术采用C+L波段扩展技术与400GZR+光模块结合,提升单光纤传输容量,助力跨域算力调度。

算力网络智能调度基于SRv6的可编程协议栈,深度强化学习算法实时解析网络状态,避开突发故障节点,动态选择最优传输路径,从而提升算力流通效率和碎片化资源利用率。

四、技术瓶颈与生态挑战

1.技术瓶颈:效能与自主性双重约束

1)大规模组网效率衰减

大规模组网时效率衰减,主要原因包括网络拓扑扩展性局限、协议碎片化、硅光互连成本高、负载失衡等,将导致千亿模型训练周期成倍数延长、能耗成本增加、稳定性变差、硬件故障率提升、算力投资回报周期变长等。

2)能耗与热力学困境

NVIDIAH100单卡功耗突破700W,8卡整机功耗约10.2kW,万卡集群总功耗达12.75MW级别,能源支出占比超运营成本40%以上。浸没式液冷虽能实现PUE降至1.1以下,但部署成本较风冷系统高出3~5倍,且维护复杂度限制其应用规模。存算一体架构尚处实验室原型验证阶段,商业化进程滞后。

3)算力可用性缺陷

大规模模型训练的不稳定性问题主要表现为训练过程中的频繁非计划中断,主要源于硬件故障、通信异常;实现训练过程稳定性,需突破快速容错恢复、动态资源调度等关键技术,这是当前万卡集群工程化落地的核心挑战[4]。

集群节点平均故障间隔时间(MTBF)小于20小时,传统检查点(Checkpoint)机制恢复耗时大于5分钟,难以满足千亿参数模型连续训练需求。多租户环境下,GPU显存时序侧信道攻击会导致模型参数泄露,造成训练时长成倍数延误。

4)存储系统性能瓶颈

EB级非结构化数据的高并发存取导致元数据管理低效,千亿级小文件查询延迟超100毫秒,扩展至万节点时I/O带宽将出现较大幅度的衰减;频繁的全量检查点(Checkpoint)存储引发NVMeSSD通道堵塞,I/O争用使训练任务周期延长。现有分布式架构难以平衡海量数据吞吐与实时访问需求,成为制约大模型训练效率的关键瓶颈。

5)运维诊断能力不足

现有的监控系统的数据采样粒度为秒级,无法捕获微秒级的网络瞬态故障,故障根因的分析依赖专家经验诊断,效率较为低下。

6)资源调度效能制约

异构资源的动态调度仍然依赖静态策略,基于强化学习的动态调度器(如Gandiva)在万卡规模下的决策延迟超过1秒,导致资源碎片化问题突出,甚至致使实时调度失效。

7)经济性失衡困境

万卡集群硬件采购成本高达几十亿元(若每套NVIDIAH100八卡整机单价按200万元估算,万卡设备采购需要25亿元,还需加上网络和存储系统等设备),加上高额电费(若每套NVIDIAH100八卡整机功率按10.2kW估算,电费取0.60元/kWh,PUE取1.1,年电费约7400万元),考虑设备折旧率、运维成本开支等,投资回报周期将拉长至8~10年。

此外,推理任务的低负载时段(约30%~40%时间段)资源闲置率超过40%,进一步恶化了经济效益。

8)自主技术成熟度局限

国产AI芯片与国际领先的NVIDIAH100的差距主要体现在算力密度(FP16算力)、能效比、软件生态及产业链协同等多个维度。此外,还有自研网络协议在跨厂商互通性不足、长距传输丢包率等方面仍需优化。

2.生态兼容性:软硬件协同壁垒

1)框架与硬件生态割裂

NVIDIA凭借其CUDA软件生态构建起了强大的技术壁垒。国内AI芯片企业面临技术挑战和生态壁垒。尽管国产AI芯片在算力上有所提升,但仍落后于国际先进水平。

2)编译优化工具链缺失

现有编译器(如MLIR)对异构硬件指令集(GPU的CUDA指令集、NPU的专用指令集、FPGA的硬件描述语言)的自动化适配代码生成覆盖率仅约六成。更棘手的是动态计算图优化,现有系统仍仰仗工程师的手动雕琢,优化效率不足理想状态的三分之一。

3.应用创新:垂直场景的破界之困

1)领域适应性局限

当万卡集群的澎湃算力遭遇科学计算领域,如同重型卡车驶入江南水乡。当前万卡集群优化主要面向自然语言处理(NLP)与计算机视觉(CV)任务,但在科学计算(如分子动力学模拟、蛋白质折叠模拟)、多模态实时推理等场景中,存在计算模式、通信模式的差异,导致资源利用率较大幅度的下降。

2)边缘-云端协同薄弱

借助于“东数西算”工程的实施,东数西存、东数西算、东数西训、东数西渲等多个领域的应用开始落地生根;与人工智能、大模型关联最密切的“东数西训”,主要是通过西部智算中心开展模型的训练,再将训练好的模型分发到东部或者边缘就近推理,最大程度的提升模型训练效率,降低应用响应时延[5]。

但是,当西部智算中心与东部边缘节点展开一两千公里的长距离数据传输时,会有超过10毫秒的传输延迟,跨层级算力调度会有在跨域传输中因协议转换和任务拆分导致的损耗。

4.人才培养:跨学科能力缺口

1)知识体系滞后

高校计算机专业课程体系与AI系统(如编译优化、光网络设计、人工智能应用等)相关的课程仍然偏少,导致企业对新入职的AI工程师仍需投入6~12个月的在职培训。

2)产学研协同不足

企业对AI应用的需求与学术研究之间仍存在鸿沟,当前绝大部分的AI集群优化论文仅就单一技术方向开展研究,未涉及对跨硬件-算法-网络协同设计的深入探讨,缺乏系统级跨层优化探索。

五、未来发展趋势

智算中心万卡集群的发展正朝着更大规模、更高性能及更广泛应用的方向演进,其发展需要技术突破、生态开放与人才储备的深度融合。

1.市场演进:规模扩张与空间重构

未来,AI大模型应用场景不断丰富,商用进程加速,智能算力需求呈现指数级增长态势。以GPT-4、Claude为代表的千亿参数模型,正在推动万卡级计算集群成为产业基础设施标配。行业头部企业(如Meta、谷歌)已启动10万卡级集群建设规划,支撑百万亿参数模型的持续训练需求。

这种规模跃升正在重构算力基础设施的空间格局;借助硅光引擎与模块化数据中心技术,集群建设已突破单一园区限制,向跨地理域的分布式架构演进;当传输距离延伸至百公里量级时,会增加传输时延,并对传输设备的无损缓冲提出了更高的要求,相应也会影响集群有效算力,需要从工程上进一步优化跨域任务响应延迟[6]。

在区域协同层面,国内新型算力网络建设呈现鲜明特色。京津冀、长三角等重点区域通过部署SRv6可编程协议,构建起“智能中枢+边缘节点”的立体化架构。这种分层设计将实时推理(如自动驾驶决策)下沉至边缘侧低时延节点,而百公里外的大型智算中心专注模型迭代训练,从而提升资源综合利用率。

2.技术突破:超异构计算范式革新

从技术演进路径分析,万卡集群的发展聚焦于三个维度:空间效率优化方面,通过芯片3D封装与液冷散热技术,实现单机架算力密度倍增;能效优化层面,采用自适应电源管理技术,降低功耗;任务执行维度,构建智能任务编排框架,实现资源动态分配。这些技术创新不仅支撑千亿参数模型的高效并行训练,在科学计算模拟、多模态内容生成等场景,亦展现出独特优势。

芯片级异构融合正重塑计算架构边界;为加速生成式AI而设计的NVIDIA Grace Hopper超级芯使用NVIDIA NVLink®-C2C互连技术,将基于Arm的NVIDIA Grace CPU和Hopper GPU架构互联,实现了高达900GB/s的总带宽[7]。

硅光子技术持续快速发展;具备高性能、大余量等优点的平层光互连技术可成为质量更高、故障率更低的光互连解决方案。在Spine-Leaf-TOR架构中,光互联技术可以将GPU扩展到上万甚至十万卡的集群[8]。

智能运维体系开启自治时代;通过对服务器性能数据的实时分析,AI可以在问题发生前预测潜在的故障点,识别出可能导致宕机的异常模式,并在问题真正影响用户之前采取措施[9]。

3.生态构建:开放架构与自主创新

国产昇腾910C芯片已实现量产交付,性能已逼近国际头部产品;构建的Cloud Matrix384基于384颗昇腾910C芯片构建,通过全对等互联总线技术实现2.8Tbps卡间带宽,训练效率达单卡性能的90%,是NVIDIANVL72集群的1.67倍;通过昇腾CANN框架支持CUDA代码迁移,开发者适配率提升至70%,训练成本下降75%[10]。

国内多个省市均在发放“算力券”,可以实现异构资源动态调度,提升碎片化算力利用率,例如成都在“算力券”的引导下,超算智算合作客户稳步增加,成都智算中心算力利用率稳定在95%以上[11]。

4.人才培养:跨学科体系重构

建议高校丰富人工智能相关课程,涵盖《人工智能、社会与人文》、《人工智能的现代方法》、《机器学习、自然语言处理、计算机视觉等》、《光子芯片设计》、《分布式训练框架》等课程,强化光电子、分布式系统与AI算法的交叉培养,培养算法-硬件-网络复合型人才。

产学研深度耦合,2024年9月,华为宣布将继续推动鲲鹏、昇腾计算产业发展和原生创新,到2025年将发展超过1000家鲲鹏原生开发伙伴,未来三年赋能百万原生人才、孵化千个原生项目,赋能千家企业原生创新;并启动10万片鲲鹏开发板和昇腾推理开发板赠送计划,以鼓励高校人才及开发者开展教学实验、竞赛实践、科技创新[12]。

六、结论

作为人工智能时代的战略基础设施,智算中心万卡集群正经历着颠覆性变革。现阶段,该领域在异构计算架构、分布式训练加速、容错机制设计及能耗控制体系等维度取得多维突破。技术演进呈现三大趋势:计算架构向存算一体方向迭代、网络拓扑向光电融合方向升级、运维体系向自主决策方向演进。然而,智算中心万卡集群的发展也面临着诸如技术瓶颈、异构计算框架的生态割裂、跨学科人才短缺、市场竞争等挑战。因此,需要各方共同努力,加强技术创新、人才培养和产业合作,推动智算中心万卡集群的健康发展。

参考文献

[1]华夏时报.专访工信部信息通信发展司负责人:2024年中国算力总规模达280EFLOPS,有序推进算力网络建设和应用[EB/OL].https://www.chinatimes.net.cn/article/143552.html.2025-03-11.

[2]姬晓婷.后DeepSeek时代,为何仍需十万卡集群?[N].中国电子报,2025-04-11(007).

[3]丁宏庆,张鹏飞,牛红韦华,等.云化的智算中心万卡集群创新与实践[J].电信科学,2024,40(12):125-135.

[4]边浙栋,傅文军,张哲超.超万卡智算集群在人工智能领域的发展和应用[J].中国仪器仪表,2025(3):21-26.

[5]证券时报网.探访中国移动贵阳数据中心:支撑全国一体化算力网络枢纽节点“东数西算”应用批量产出[EB/OL].https://www.stcn.com/article/detail/915476.html.2023-07-10.

[6]移动通信网.中国移动发布《面向超万卡集群的新型智算技术白皮书》,助力智算基础设施迈向新台阶[EB/OL].https://www.mscbsc.com/viewnews-2323651.html.2024-04-30.

[7]英伟达中国.为加速生成式AI而设计的NVIDIAGraceHopper超级芯片全面投产[EB/OL].https://blogs.nvidia.cn/blog/nvidia-grace-hopper-superchipsdesigned-for-accelerated-generative-ai-enter-fullproduction/.2023-05-28.

[8]半导体行业观察.AI算力狂飙,硅光互连破局![EB/OL].https://finance.sina.com.cn/roll/2025-04-29/doc-ineuuwaf5316025.shtml.2025-04-29.

[9]阿里云.智能化运维:AI在故障预测与自我修复系统中的应用[EB/OL].https://developer.aliyun.com/article/1574264.2024-07-30.

[10]封面新闻.华为云384超节点已实现AI算力突破,算力革命已不可阻挡[EB/OL].https://baijiahao.baidu.com/s?id=1832231242874914362.2025-05-15.

[11]国家数据局.数字经济创新发展试验区建设案例之十七|“算力券”助力夯实算力底座[EB/OL].https://www.nda.gov.cn/sjj/zhuanti/ztdsjblh/ztxwfb/0912/20240912112429730404517_pc.html.2024-09-08.

[12]华为.加速鲲鹏昇腾原生创新,助力千行万业共赢数智美好未来[EB/OL].https://www.huawei.com/cn/news/2024/9/hc-kunpeng-ascendopeneuler.2024-09-21.

作者简介

丁聪,高级工程师,咨询工程师(投资)、注册监理工程师、信息系统项目管理师(高级),上海市节能环保服务业协会绿色数据中心专业委员会副主任,CDCC数据中心专家技术组专家、设计师技术组副主任委员,中国电子学会高级会员,中国勘察设计协会电气分会杰青组委员,中国通信企业协会团体标准委员会专家,上海市智能建筑建设协会青年专家委员会委员,长期从事数据中心建设项目的咨询、设计工作,参与出版行业专著、译著三本,主编、参编地方标准、团体标准十余项,发表学术论文三十余篇。

编辑:Harris