|

||

咨询QQ: 杂志订阅 杂志订阅 编辑 编辑 网管 网管 培训班 培训班 市场部 市场部 发行部 发行部电话服务:  010-82024981 010-82024981 | ||

|

||

在数据中心能耗中,IT设备的能耗居首,其次为制冷能耗;以一个PUE=1.5的数据中心为例,电力系统消耗5%~10%,接近25%~35%是制冷能耗。探索低能耗提升效率,优化TCO成本的绿色节能制冷系统方式是本文探索的重点。

1 数据中心制冷系统节能的界定

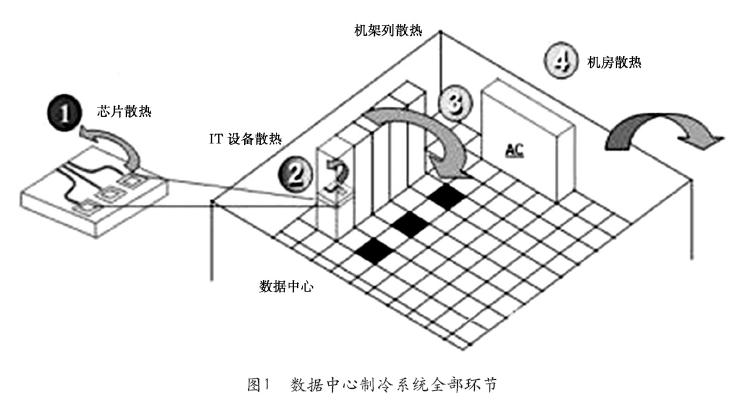

数据中心制冷系统的绿色节能,由三个主要的指标来界定和评估:最大化制冷效率、最小化能量传递能耗和系统成本最优。因此对于数据中心制冷系统节能方式将从两个维度进行分析评估,即从热量传递途径横向进行剖析和制冷系统纵向的比对。通过对制冷系统的分解,可以划分为四个级别(见图1):

①从冷却数据中心的IT设备的芯片级别开始,是设备部件级别的冷却级,为第一级;

②IT硬件设备散热到机架,是硬件设备的冷却级,为第二级;

③若干设备组成的机架和机架列散热,是机架和模块级别的冷却级,为第三级;

④机房内部热量被冷却系统传导到室外,完成整个制冷冷却系统的流程,为第四级,主要是纵向的不同类型制冷系统的对比。

这四个级别可以在每个层级进行分析对比,寻找每个级别最佳节能方式。最后,运营管理和能效管控系统是实现这些节能方式发挥效果的重要手段。

2 第一级别制冷系统节能方式:芯片/IT节点设备冷却

(1) 风冷散热片

风冷散热片是最常见的散热器件,一般是导热性能比较好的铝或铜等材料,加工成散热翅片以增加散热面积和效率,通过特殊的介质(通常是导热硅脂)紧贴住发热量很大的芯片,然后再在散热片上固定一个风扇来增加流速,提升换热能力,更快带走热量,从而达到对芯片散热的目的。提升风冷散热的途径是提高散热面积、提高换热系数、提升辐射散热效率、使用散热效率更佳的材料、粘合充分接触保证降低传导热阻等,风冷散热片如图2所示。

风冷散热片的优点是简单实用,且价格低廉。其缺点:

①冷却效率不高,不能完全将CPU发热量散发出去,仅依靠传导和对流容易达到风冷散热器导热极限;

②随着风扇的功率和转速的增大,噪声也随之增大;

③由于风扇是运动部件,较易损坏,对可靠性有一定影响。

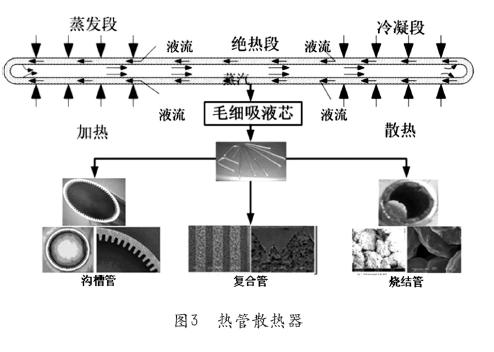

(2) 热管散热器(见图3)

热管散热器对比常规的风冷散热片有所改变,在最贴近CPU部分使用高效的热管替代常规金属基座。热管是通过封闭的金属腔体和毛细吸热芯,充分利用了换热工质在热端蒸发后,在冷端冷凝相变(即利用液体的蒸发潜热和凝结潜热)和热传导原理,使热量快速传导透过热管将发热物体的热量迅速传递到热源外,其导热能力高于同等质量金属达到数量级的级别,而且平板型热管的热温度场均匀,局部换热量大,成为更佳的散热解决方案,当然成本有所增加。

(3) 液冷

液体冷却通常采用特种或特殊处理液体直接或近距离间接换热冷却芯片或者IT整体设备。液体冷却分间接液冷和直接液冷。

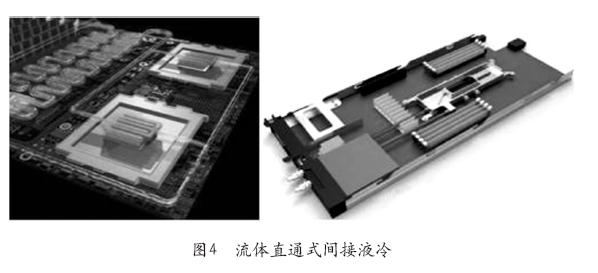

间接液冷实质是冷媒与发热元件被导热材料分离,不直接接触,而是通过液冷板、液冷头等高效热传导部件,将被冷却对象的热量传递到冷媒中,冷媒再通过制冷系统实现冷媒的循环和降温。

采用间接冷却的液冷散热系统,对IT设备没有明显改动,仅需将原风冷散热片替换为液冷散热片,成为冷媒换热系统。常规情况下,芯片工作温度为20~60℃区间,可以使用无相变的水(离子水+铜缓蚀剂)或者水氟转换系统进行换热,通过外部冷却水或冷冻水系统实现系统换热。该系统重点在于选择合适的冷媒,并且设计复杂的冷媒管路到达每个机架,为每个IT设备设计无滴漏的快速接头,保证液冷系统支持热插拔,实现维护时不中断整个系统,并避免换热介质流出。流体直通式间接冷却如图4所示。数据中心中较多的循环管路,成了故障维护和水力平衡的难题。

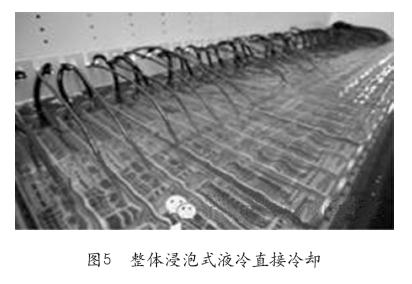

直接冷却是采用密闭的氟化液等矿物质直接浸泡冷却IT设备的芯片、内存等发热部件,形成密封的一级散热循环系统,而二级循环系统可以采用自然风冷或者冷却水系统进行冷却。对比间接制冷系统,直接冷却对发热元器件冷却的均匀度更好,冷却液温度可以更高,尤其是选择一定温度下相变的液体,局部散热能力强,散热效果更好;比如对于60℃的芯片,可以采用50℃冷却水或冷却蒸发温度在55~60℃的冷媒流体,因此,即使夏季45℃高温天气,也可以实现直接新风冷却或者冷却塔,从而数据中心实现全年自然冷却,降低能耗,这对于全球温带和热带区域实现制冷系统的高效带来了突破,是有竞争力的制冷方案。整体浸泡式液冷直接冷却如图5所示。

但是液体冷却面临较多挑战:

①目前液冷更适合于高功率密度和全新的服务器架构设计,无法兼容目前主流的风冷的服务器架构和数据中心设计,改造难度大。

②因规模和应用范围的限制,尤其是部分IT设备部件材料在直接冷却液体中的兼容性和化学稳定特性需要长期测试验证,液体冷却的成本较高。

③系统设计有待项目验证和优化,如对于每个IT设备液冷需要大量的管路优化设计和水力平衡及流量控制、冷媒冷却温度的控制和二级循环冷却管路的匹配联动控制等。

④IT设备的维护更换需要液冷支持快速插拔无渗漏的更换,供电电缆和传输的光缆连接器等有源部件的密封和散热都需要优化设计。

在这一级别的换热环节中,不论散热片还是热管均需要IT设备级别的风扇强制对流换热,二者的区别无非是使用换热效率和温度场均匀度方面存在差异,风冷散热片的散热极限一般为40W/cm2。

利用腔体内的沸腾或者热管配合风冷强制换热,常规做到100W/cm2,利用IC工艺制成的多根微型热管阵列的水冷泵循环,其冷却功率可达200W/cm2,而当水的流量为10cm3/s,水的温升为71℃时,冷却热流高达790W/cm2,是目前散热能力最大的水冷装置。

3 第二级别制冷节能方式:IT设备机架散热

这一级别的换热是IT机架与数据中心区域环境的热交换,可以将换热方式划分为两种模式:一种是直接风冷换热或风冷结合某种高效液冷换热单元部分进行接力传递换热;另一种是直接浸泡换热。

(1)机架的风冷换热

机架的风冷换热的核心是在实现IT设备正常工作的均匀温度场基础上,实现温差和风量的匹配均衡,其节能实现的途径主要为两种:第一种是在保证IT设备正常工作温度基础上,尽量提升送风温度,保证合适的风量,降低上一级换热系统的能耗,实现系统的节能,是主要的节能方式;另一种是大温差减少送风量对应减少风机能耗的节能方式,调风量降低风机能耗主要是使用直流或者变频风机根据IT设备工作情况进行自动调节,但是对于数据中心整个制冷环节,1台250W的服务器常规配置两个12~15W的风扇,风机能耗占比为5%左右,即使可以采用变频或者直流风机对比定频风机实现10%~20%的节能,但是整体节能空间仅(10%~20%)×5%=0.5%~1%,节能空间有限。

(2)IT机架气流组织的改善

IT机架可以在满足运营安全的情况下,去除机柜前后柜门改善气流组织。目前机架常规的柜门开孔率在40%~70%,去除柜门,可以有效降低送风和回风阻力。

更有效的气流组织改善方式是IT设备机架的进行盲板密封,可以将IT机架前后进出风空间有效密封,避免服务器吸入热通道回流热风而导致的局部过热,增加IT设备的能耗,另外,这一措施为提升整体送风温度做准备。

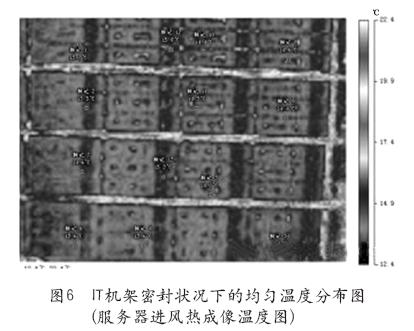

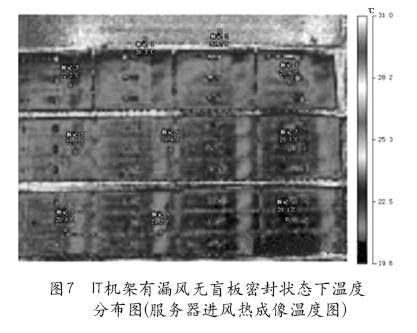

笔者在某运营的数据中心中,对比测试机架密封与不密封情况;在风冷空调送风13~14℃时,IT机架密封时正面进风温度场比较均匀,稳定在14~15℃;而当机架没有盲板密封情况下,因机架热回风容易短路回流,整个机架温度场会提升到20~22℃,服务器风温度提升到30℃,出现局部区域过热的趋势。图6和图7分别是IT机架在密状态下和有漏风无盲板密封状态下的温度分布图。

(3) IT机架局部高效换热

IT设备机架散热效率提升,主要采用各种近距离高效换热设备,如无风扇背板换热器和热管换热器、有源的定点风机盘管(置顶/机架架空地板下均可)、列间空调、冰箱式内部风机盘管等;因应用场合和对于水进入机房的考虑不同,循环工质可以选择水或者氟利昂等介质。

近距离制冷单元(见图8)对比远距离的机房空调等,有两个亮点:一是机柜级别的换热循环,循环路径仅为机柜的深度或者高度,可以减少循环路径中的漏风或者短路影响,即减少循环风机的能耗,风机能耗同比降低10%~20%。但因为风机能耗在整体能耗所占比例低,节能空间有限。二是直接最短距离与IT设备机架的热回风直接换热(IT设备热回收常规在30~40℃),可以将循环换热供回水温度提升到17℃/22℃,对比常规数据中心制冷系统设计的循环供回水温度(如10℃/15℃)提升了7℃,节能环节可以转移在外部制冷循环上。有的文献对各种空调系统的能耗系数做了比较,指出机房级别的风冷空调能耗最高,其次为高温冷冻水空调,再次是机架级别的列间空调和水冷背板系统,最优为芯片级别,其能耗最低。所以,减少制冷环节中的损耗、更有效的冷却换热设备、更短途径的冷却发热设备,能实现更低的能耗。

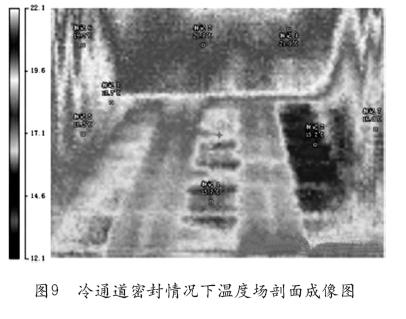

4 第三级别制冷节能方式:机架列-模块房间节能

在机架列到数据中心机房的节能,主要是通过房间和区域的气流组织优化,提升机房空调的利用效率,对于IT设备发热源进行相对精确的冷量匹配,温度场调优,实现最大化利用冷风冷却IT设备,实现节能。节能方式有冷热通道进行分离,再增加送风地板或回风吊顶,有组织的进行气流组织引导,有效减少同等散热量情况下的风量和压头损失,从而降低风机能耗;再次将冷通道或者热通道进行密闭,从而保证送风温度场的均匀,避免局部热点,目的是提升送风温度对应提高制冷系统的蒸发温度从而实现制冷系统压缩机功耗的降低,最终在第四级别的制冷系统级实现整体节能。图9为典型冷通道密封情况下热成像剖面图,下部为地板风口,上部为通道门,两侧为服务器进风口。

5 结束语

降低数据中心的制冷能耗,是优化PUE的重要手段。探索低能耗、提升效率,优化TCO成本,构筑绿色节能的制冷系统将成为建设绿色数据中心的重点。

作者简介

韩玉,就职于阿里巴巴集团技术保障部,该部架构委员会七名委员之一兼数据中心首席架构师,中国数据中心工作组专家委员,制冷学会数据中心工作组委员,国内多个数据中心的在编标准、技术规格的参编者。

编辑:Harris