|

||

咨询QQ: 杂志订阅 杂志订阅 编辑 编辑 网管 网管 培训班 培训班 市场部 市场部 发行部 发行部电话服务:  010-82024981 010-82024981 | ||

|

||

1 数据中心液冷技术背景

三年前,我们发表了《服务器液冷技术潜力分析》,当时是出于对新型服务器产品的角度,如今三年过去了,相关服务器级冷却技术的成熟度和市场发展也都有了长足的进步。

由于数据中心各项服务目前仍处在买方市场,以及相关光缆,人力均受限,就近一线城市客户与客户的客户,仍成为主要的选址原则。

另一方面,随着全球能源格局变化和减排的需求,国内一线城市的单位产值能耗及排放水平日益趋严。同时由于数据中心基础设施市场的成熟,以及边缘数据中心的兴起,使得全国网络的加速与不均逐步开始减少。在一线城市尤其是大型城市,中大型以及超大型数据中心在传统的冷却架构下,其能耗和排放指标将越来越难以接受。

2013年2月工信部发布了《关于进一步加强通信业节能减排工作的指导意见》,要求到2015年末新建大型云计算数据中心PUE值低于1.5,力争使改造后数据中心PUE值达到2以下。2014年7月北京市人民政府办公厅发布《北京市新增产业的限制和禁止目录》2014年版,禁止新建和扩建数据中心,PUE值在1.5以下的云计算数据中心除外。

2018年9月26日《北京市新增产业的限制和禁止目录2018年版》(见表1)。要求禁止新建和扩建互联网数据服务/信息处理和存储支持服务中的数据中心,在中心城区(东城区、西城区、朝阳区、海淀区、丰台区、石景山区)及北京市副中心(原通州新城)之外的城区,才允许建设PUE值在1.4以下的云计算数据中心。

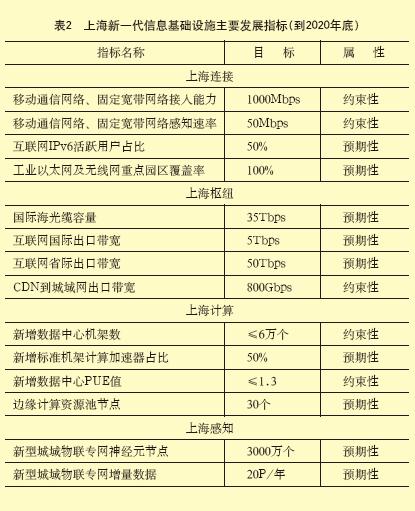

2018年10月29日上海市经信委发布已经经过市政府同意的《上海市推进新一代信息基础设施建设助力提升城市能级和核心竞争力三年行动计划(2018-2020年)》(见表2)。其中提出主要目标之一:到2020年底,创建存算一体的数据中心资源高地。数据中心与超算中心实现规模发展、存算均衡、空间集聚、节能降耗。建设具备E级计算能力的超算中心,数据中心机架数达16万个,新建数据中心综合能源效率指标(PUE值)不超过1.3,边缘计算资源池节点实现合理布局。

新建机架控制在6万个,总规模控制在16万个。推动数据中心节能技改和结构调整,存量改造数据中心PUE值不高于1.4,新建数据中心PUE值限制在1.3以下。开展计算资源布局规划和资源配置方案研究,实施技术试验及模式研究。依托数据中心布局,建设基于中央处理器(CPU)、图形处理器(GPU)等的计算中心,面向人工智能的计算加速资源占新增数据中心机架总量的50%。

2 数据中心液冷技术简介

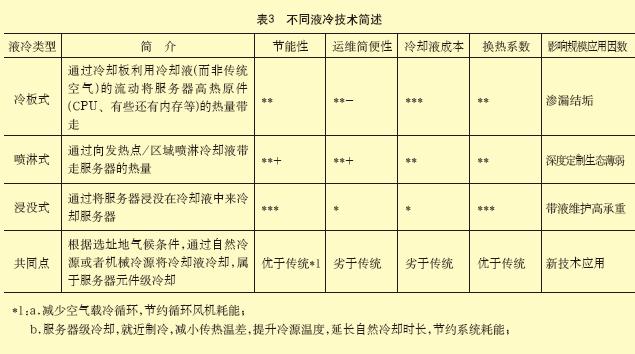

数据中心常见液冷服务器目前主要有三种形式,冷板式,喷淋式,浸没式(见表3)。

冷板式:通常无法匹配硬盘及其他低热元件,因此仍需要服务器内空气散热。冷却液通常采用去离子水,降低泄露事故导致短路概率,保持高比热,低粘滞系数。

喷淋式:不适用机械硬盘。冷却液通常采用绝缘性能及换热性能均较优秀的液体。

浸没式:对于光模块需要定制密封,承重需求远高于其他两种液冷方式。冷却液通常采用氟化液,绝缘,难燃,低毒,低腐蚀性。

共同点:定制服务器,动力维护与IT维护交叉,对于动力维护(非IT的基础设施)的及时性和高效性提出新的要求,对服务器厂家及相应上下游生态链提出了新的要求。

3 数据中心液冷应用潜力分析

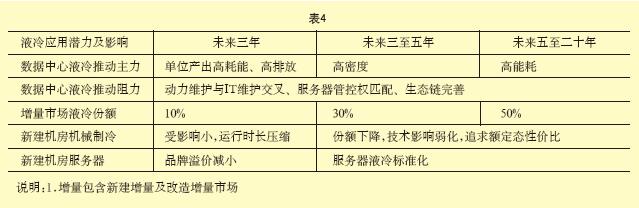

正向因数:数据中心单位产出能耗、排放高、高密度、高能耗。

负向因数:服务器管控权匹配、动力维护与IT维护交叉、生态链尚未完善。

单位产出能耗、排放高

随着数据中心的神秘面纱被揭开,越来越多属地政府管理部门意识到数据中心基础设施的建设和运营其单位产出能耗及排放在一线城市均属于拖后腿角色。尤其是随着科学和持续发展观的贯彻,能耗和排放的管控日益趣严且层层下压。

这从作为排头兵的北京和上海近年来的政策变化即可体会一二。2018年9月26日《北京市新增产业的限制和禁止目录2018年版》基本禁止新建和扩建数据中心,只在郊区且是AI、边缘等新兴方向的云计算中心,且PUE值低于1.4才开了个口子。

《上海市推进新一代信息基础设施建设助力提升城市能级和核心竞争力三年行动计划(2018-2020年)》到2020年,必须是新建PUE值低于1.3,存量高于1.4将外迁或改造,且新增至少50%面向AI。

虽然看起来已经很严苛,但是未来更严的可能性超过50%,每一到五年出个新的更低的控制指标是很可能的。

早在2012年笔者曾经基于北京工况,就传统架构(三代智能冷源+变频泵与变频风机,12/18供水)推算过其理论PUE值为1.38,上海约为1.42;且未考虑温湿度精度控制及新风等所带来的加热加湿用电。即使考虑UPS更新换代甚至是市电直供,带来ELC下降约0.05/0.07,对于北京以南,显然传统架构非常难以满足核准需求。

液冷并不是唯一的解决方案,甚至还不是性价比高的解决方案,但是如果管控再进一步加码呢?对于新建机房将不失为一个好的解决方案。

液冷方案浸没及喷淋不需要服务器风机及末端空调风机,即使冷板也可大量节约服务器及末端空调风机功耗。

节约末端空调风机传输功耗约可降低CLF约0.063-0.133,但是根据现行PUE测量规则,由于IT设备耗电量同比例甚至更大比例下降,导致PUE值不降反升。(预计升幅在0.05~0.08之间)常见供液温度可高达28-30℃,可大幅提高机械制冷COP,及延长自然冷却时长。

甚至大部分地区可以省去机械制冷系统。可以轻松将CLF下降至0.07,即使供电采用传统架构,供配电及部分不适应液冷IT元器件采用传统冷却,总体PUE值全国范围内控制在1.26以下,以三大IDC排头兵为例:北京1.17,上海1.23,广州1.26。

高密度

数据的发展是无限的,而土地尤其是热土注定是有限的。从长远来看密度必定上升。

即使从短期来看,以AI、5G和IOT等为主兴起的边缘计算来看,所谓的边缘是就近客户就近数据,而实际上往往处于发达城市边缘,其土地价值会高于所谓的大型超大型集中式云计算核心,其发展会趋向更高密度而节约土地成本,但是需要便捷和智能的维护。

而如果从技术的另一个走向,集中式大型超大型云计算/存储数据中心地处边缘,从产出角度也会追求高密度。限制高密度的是高密下的生态链成本,其最终会采用最经济的密度。

随着技术发展,越高密度,其单位密度的成本必然下降。目前常规的房间级制冷适用单位机柜密度在0~11kW左右;而常规行级制冷适用密度在6~20kW左右;机柜级制冷适用密度在8~30kW左右;再大的密度,服务器级的空气冷却已经无法适应。

我们举个简单的例子,比如常规200W的1u服务器,服务器风扇功率占比5%;当负荷提升x倍,风机风量提升x倍,空间不变,静压提升约x2,功率提升约x3倍,当x>2.582时,总功率增加速度将低于风机功耗增加速度,导致实际计算负荷下降。即使考虑普通标准服务器空气组织效果未专门设计优化,风机效率不高,可以提升100%(静压下降,效率提升导致风机功率下降50%),42u配满,单机柜功率密度37.6kW。目前常规实际密度在2kW/柜,头部客户(<20%),平均不超过10kW/柜。从短期(未来五年)来看,高密度因子对液冷的驱动力仍然不足。

高能耗

根据相关调查,目前部分IDC热点开发区/区县,数据中心耗电量已达全区的50%,美国早在五年前,数据中心耗电已经占到全国2%的水平。

我们假定现在全国数据中心耗电占比p也达到2%,每年平均增速m约7%,全国用电每年平均增速n约3%。x年后数据中心耗能达到不可持续占比o,全国耗电60%用于数据中心。

p×((1+m)/(1+n))^x

x<89年;

即使m调至30%,n调至5%,x<16年;

4 服务器管控权匹配

液冷需要定制服务器,需要在服务器的采购及运行管理上,有相应的权限。而这些权限很可能分散在不同的主体和部门内,且并不属于能耗和排放压力承担部门。

如需破解,对于IDC,可借单位产出能耗压力,共同驱动IDC转向云计算或者混合参股。对于EDC,驱动建设和运营部门高效融合。驱动IT运营与设施运营融合。

动力维护与IT维护交叉,对于传统市场,动力维护与IT维护不同的团队甚至是公司,有人的地方就有江湖。如需破解,可以驱动IT运营与设施运营交互与更加专业。

生态链尚未完善

生态链的完善,需要时间让技术成熟,也需要深度让利,让利润推动生态链随着时间及市场发展逐步完善并蚕食其他相关技术方向的份额。

寄语:在一线城市,数据中心耗能将逐步面临总量控制(影响新建),现有排放水平固化(影响低负荷),非核心移出(单位产值耗能高/非核心细分行业)(见表4)。

液冷将不失为一个好的解决方案,是时候进行技术储备了,即使对于很多人来说看起来还很遥远。

作者简介

付宝福,国家注册公用设备工程师,发愿生命不息向善不止的数据中心基础设施资深人士,专注于数据中心全寿命周期运营优化,竭力探索数据中心高效与永续运行之路。

编辑:Harris