|

||

咨询QQ: 杂志订阅 杂志订阅 编辑 编辑 网管 网管 培训班 培训班 市场部 市场部 发行部 发行部电话服务:  010-82024981 010-82024981 | ||

|

||

通过研究GB50174《数据中心设计规范》和ASHRAETC9.9.2011关于数据中心基础设施环境参数,提出湿度控制对于服务器运行可靠性尤为关键,湿度控制需严格控制上限。湿度控制稳定,可以一定程度上降低服务器故障率,该结论还需工作中更多的数据验证。服务器入口温度,并非越高越好,还需考虑IT设备能耗,目前看主流服务器入口温度大概25℃时,达到总体能耗最优点。

提高水系统供水温度,通过数据研究,发现可以直接提高冷机性能,同时还可以延长免费制冷时间,大大降低了系统运行费用,但水温提升,缩短了应急时间,运维工作承担了一定风险。水系统控制节能优化,通过研究厂家理论数和实测数据,发现两台变频离心式冷机部分负载相比1台冷机满载运行时,系统能耗明显降低。随着业务量不断增加,冷水机组实际承担的制冷负载是不断调整的,运维工程师还需根据本方法,不断调整运行策略。冷却塔风机频率一般通过趋近室外湿球温度控制,在室外高湿度时(下雨前后和下雨时),冷却塔的风机控制需要人为动态调整趋近度,避免不必要电能浪费。

数据中心暖通系统运维工作,责任重大,运维人员需持续在工作中提升技能,了解设备性能,通过对运行数据变化的高度敏感性,优化调整运行参数,保障业务安全高效运行。

大数据、云计算、物联网、智慧城市、5G等信息化技术都依赖于数据中心的发展而发展,数据中心作为这些业务的载体,基础设施建设和运维需求井喷式增加,其中暖通系统运维工作,肩负着重要的使命。运维工作一项考核项就是PUE(电能使用效率),PUE值越接近1表明能效水平越好。同时,面对数据中心系统的复杂性,以及保障业务运行的绝对安全可靠性,运维工作也存在很多风险和挑战。

本文包括理论研究和个人实践,总结了数据中心运维工作遇到的几个实际问题,以及个人的一些分析和思考。

1 机房环境参数

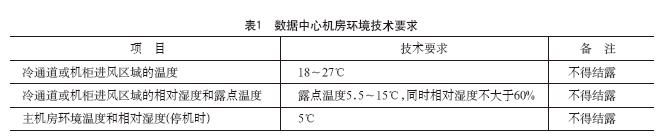

《数据中心设计规范》(GB50174-2017)对于主机房内的温度、露点温度和相对湿度较以往的设计规范有了新的要求[1]。机房环境参数要求如表1。可以看出然新国标对于相对湿度没有下限要求,但是根据冷通道或机柜进风区域的温度和露点温度的要求可以算出。冷通道或机柜进风区域的相对湿度宜为冷通道或机柜进风区域的温度在露点温度允许围内的对应的相对湿度。

美国采暖、制冷与空调协会(ASHRAE)对于数据中心的推荐范围:18~27℃,该温度指的是进入电子设备的空气状态,即进风状态。设备长时间在推荐值范围之外运行尤其运行在接近允许运行环境的极端值时,可能导致设备可靠性降低和寿命缩短[2]。

通过国内外行业标准,并结合笔者在某数据中心现场运维经验,认为机房内的相对湿度不应简单的控制在60%以下,而是应该结合精密空调回风温度、送风温度和机房内的实际露点温度,来确定达到露点温度情况下的相对湿度的上限值。实际机房运维中,应根据实际测量的机房露点温度,合理设置精密空调除湿、加湿器加湿的相对湿度设置点以及精密空调的送风温度设定点,将送风相对湿度保持在35%~65%,一方面可以在很大程度上降低机房加湿、除湿能耗,打造绿色节能数据中心,另一方面可以提高数据中心机房计算机设备的寿命及可靠性,为数据机房安全生产提供强有力的基础环境保障。

另外,笔者所统计的某数据中心项目,运维统计发现某服务器功率模块第三季度(7月份、8月份、9月份)故障率偏高,大概在0.02%,尤其7月份最明显。而到了第一季度和第四季度,故障率大大降低了。笔者调研几个数据中心机房月度、周度报告数据,发现夏季季节数据中心机房实际湿度运行数据会明显上升,尤其是夏季雨季前后湿度控制出现了一些短时间偏差。笔者认为夏季湿度的增加可以推测是机房服务器故障率的原因之一。基于缺少大量实际数据的验证,从理论研究发现,机房湿度控制的最高值是有腐蚀损害的程度决定的,由于侵入的污染物随着湿度的增加,活性会变大[3]。

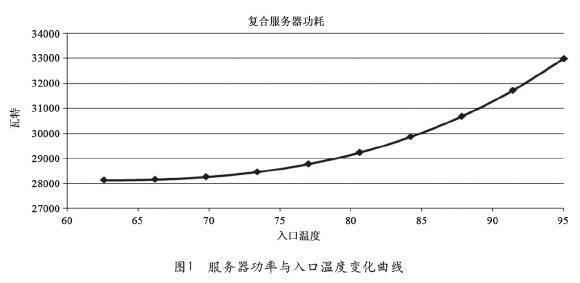

对应数据中心基础设施运维从业者,凭借之前一些早期的经验,通过调高服务器入口温度,我们可能会看到PUE的降低,但是数据中心的整体能耗或许会增加,原因是随着入口温度的增加,服务器的风扇功率会增加。如图1,当服务器入口温度升高时,服务器功率随之上升,且上升越来越快[4]。

惠普、戴尔、华为等厂家的常规服务器运行的费用,包括计算机的电源功耗、机械设备的电源功耗、电源转换损耗、照明等。惠普在Uptime的研讨会,报告了服务器在四个不同的服务器入口温度的条件下,测试了对应的PUE值和运行的总体费用[5]。正如人们所料,随着温度的升高,他们虽然提高了机电设备的效率,PUE值下降了,然而,运营总体能源成本并没有与PUE值对应下降。研究表明,如表2所示,入口温度越高,PUE数值越低;随着入口温度增加,总体能源费用呈现先减少再增加的趋势,在入口温度约25℃时,总体能源费用是最低的。

通过该研究报告的结论,证实了入口温度某范围内升高,服务器风扇的转速会上升到某一速度,这样会导致服务器功率的升高,其消耗的能耗大于机电设备节能的能耗。

目前国内某两家大厂级互联网云计算数据中心,对于服务器入口温度也控制在24±2℃,该数值也与本研究结论相符。但对于国内大部分数据中心运营商,有的数据中心过分追求较低地PUE数值,殊不知总体运营成本却增加了,有的数据中心过分追求低入口温度,但牺牲了一定的总体能源费用。

笔者在某数据中心项目运维过程中,整理运行参数,通过调整服务器入口温度,从23℃调整为25℃,发现PUE数值降低了不到0.01,而总体能耗功率略微下降;从25℃调整为27℃时,发现PUE数值又降低了0.01,而总体能耗功率略微增加。因此,笔者认为该项目服务器入口温度基本控制在25±1℃,用于指导数据中心一线运维。

2 冷冻水供水温度

大型数据中心项目,目前广泛采用的集中式空调系统的冷冻水系统,细分有一次泵系统和二次泵系统。大型水系统,供水温度作为关键指标,对整个空调系统的能耗、投资均有着至关重要的影响。

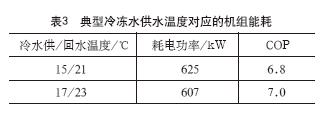

为研究供水温度的变化对系统能耗的影响,选取北京地区某数据中心项目制冷量1200RT的冷水机组为例,选型机组冷冻水供水温度对应的能耗如表3所示。

本项目中冷却塔逼近度取6℃,冷冻水供水温度对应的免费制冷时间如表4所示。通过以上理论数值,结合笔者在北京某数据中心项目,笔者有几点体会:

(1)较高冷冻水供水温度有益结果:

①较高的冷冻水供水温度能够提高冷水机组单机的制冷效率COP。笔者项目选型的为市场主流品牌档次离心式压缩式冷水机组,根据厂家的选型参数,冷冻水供水温度每提升1℃,冷水机组COP可提高2%~2.5%左右;

②较高的冷冻水供水温度,可提高空气调节显热比;提高到一定数值后,可实现干工况运行,减少加除湿部分功耗;

③对于北方大部分地区利用自然免费冷源的大型冷冻水系统,较高的冷冻水供水温度,可增加免费冷源的利用时间。温度每提升1℃,完全自然免费制冷小时数增加200~250h,降低了大量空调能耗。同时,免费制冷模式时,冷水机组压缩机关闭,一线运维人员压力大大降低。

(2)较高冷冻水供水温度不利影响:

①同空调末端配置条件下,较高冷冻水的供水温度会使末端服务器设备的进出风温度升高;

②同等温度工况控制条件下,较高冷冻水的供水温度会使空调末端精密空调设备换热温差减小,制冷量衰减,需配置数量更多(或单台设备制冷量更大)的空调末端设备,造成空调末端能耗或造价升高,总体投资分析需进一步探讨;

③较高冷冻水的供水温度,减少了服务器温升的空间,运维风险加大。

3 自动控制系统节能优化

笔者曾在某数据中心项目一线运维技术管理,担负空调制冷系统的运行保障和节能优化工作。本文只选取其中两个典型场景,阐述节能控制方案。

(1)场景一:变频冷机台数控制

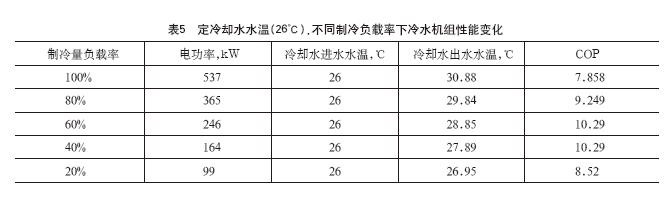

找到约克厂家变频离心式冷水机组理论性能曲线,在定冷却水温度(26℃)时候,冷水机组不同制冷负载率下,冷水机组性能变化(COP,单位kW/kW),如表5。

通过上表,该型号冷水机组在制冷负载率40%~60%之间时,性能最优。实测该项目研究冷水机组性能,当开2台冷水机组,对应开2台冷却泵和2台冷冻泵,开1台冷水机组时,对应开1台冷却泵和1台冷冻泵。记录数据如表6。

通过实测数据,发现两台变频离心式冷水机组开启时,系统能耗明显降低,该结果直接指导一线运维,大大降低了动力侧运行能耗。需要注意的是,随着业务量不断的增加,冷水机组实际承担的制冷负载是不断调整的,因为运维工程师还需要根据本研究方法,不断的调整运行策略。

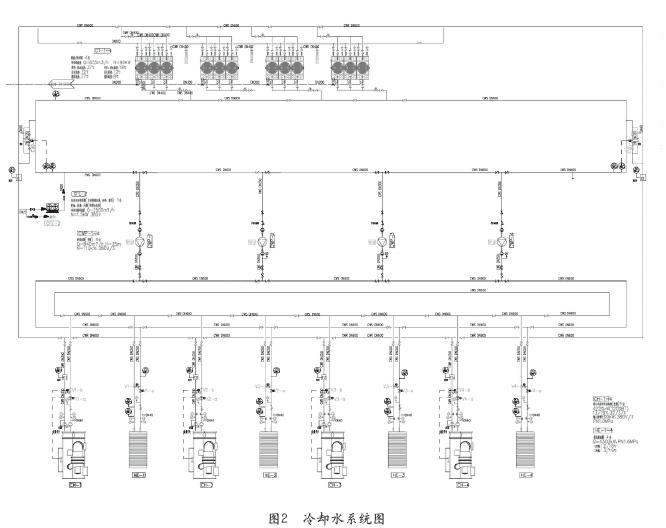

(2)场景二:冷塔控制冷却塔风机变频一般是通过趋近室外湿球温度控制。笔者通过在北京某数据中心项目,阐述控制优化过程。冷却水系统如图2所示。

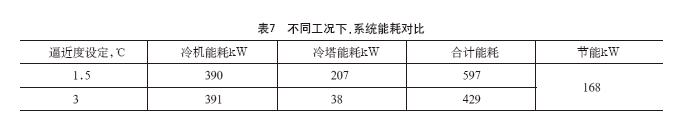

测试场景:室外环境干球温度24℃,相对湿度94%。通过调整冷塔风机频率控制逼近度(室外湿球温度与冷却塔塔盘水温的差值),记录数据,如表7。

测试发现,趋近度调大后,冷机能耗几乎不变,冷却塔能耗大大降低。通过采集的动环数据发现,调整前冷却塔几乎都满频率运行,可以认为冷却塔已经“使尽全力”也无法达到人为设定的趋近度。因此,当室外高湿度时(下雨前后和下雨时),冷却塔的风机控制需要人为动态调整趋近度,避免不必要的电能浪费。

4 结束语̶̶总结和思考

数据中心暖通系统运行,运维人员需要积极进取的心态和专业的技能,保障业务运行的连续性和稳定性。总结以下几点:

①数据中心湿度控制稳定,可以一定程度上降低业务服务器故障率,该结论还需以后工作中更多的数据验证;

②数据中心服务器入口温度的最优点,需结合实际动力和IT设备情况,进行研究和测试,目前看主流的服务器入口温度在25℃时,总体能耗水平最优;

③提高冷冻水供水温度,可以直接降低冷机能耗,还可以延长免费制冷时间,但需结合运维团队的整体实际力量,因为会降低应急时间;

④数据中心的水系统节能控制优化,运维人员需通过对运行数据变化的高度敏感性,了解设备性能,优化调整运行参数,保障业务安全高效运行。

参考文献

[1]GB50174-2017,数据中心设计规范[S].

[2][2] ASHRAE TC9.9.2011 Thermal guidelines for data processing environments [M]. 4th. USA :ASHRAE,2015.

[3]Jimil M. Shah,Oluwaseun Awe,2017,Qualitative Study of Cumulative Corrosion Damage of IT Equipment in a Data Center Utilizing Air-Side Economizer[J],Journal of Electronic Packaging,DOI:10.1115/1.4036363

[4]David Moss,DellInc,JohnH.Bean.服务器入口温度升高造成的能源影响,施耐德第138号白皮书,2019.

[5]Ian Seaton.AirflowManagement Considerations for a New Data Center Part 1: Server Powerversus Inlet Temperature[DB/OL],2017,https://www.upsite.com/blog/server-power-versus-inlet-temperature.

作者简介

蒋明贺,男,硕士,北京金山云网络技术有限公司IDC基础设施工程师,参与了阿里云、华为云、金山云等多个数据中心基础设施运维管理或建设工作。

赵春晓,中国建筑标准设计研究院数据中心设计研发部门暖通专业设计师。主编参编过多项标准,主编中国电子学会团体标准《数据中心人才标准》;参编《数据中心蒸发冷却空调技术规范》、《绿色微型数据中心技术规范》。

吴晓晖,男,硕士,中国建筑标准设计研究院数据中心研发部副主任,高级工程师,北京工业大学动力工程专业硕士研究生指导老师;国家绿色数据中心工作专家委员会顾问。参编国家标准《数据中心基础设施运行维护标准》,团体标准《数据中心人才标准》,《绿色数据中心评估准则》等。主持完成大中小型数据中心项目几十项,集团内科研课题研究3项,获得数据中心相关发明专利一项,软件著作权2项。

编辑:Harris