“到2020年,行业前15%的企业都将采用机器学习;到2023年,人工智能将取代50%的IT业务工作量”。

“到2020年,行业前15%的企业都将采用机器学习;到2023年,人工智能将取代50%的IT业务工作量”。

也许你还没有察觉,但IDC的这些预测数据在提醒着我们每一个人,人工智能时代正加速到来,其已不再仅仅是实验室中的数据模型,产业界正在不懈地探索人工智能应用落地的路径。

政府、金融、互联网、新零售、新制造、医疗,未来这六大行业应用AI的3年复合增长率将超过30%。不过要说的是,人工智能“扑面而来”,能够对其起到关键支撑作用的底层基础设施已经准备好了吗?

算法、算力、数据被称为推动AI发展的“三驾马车”,到今天深度学习算法已经形成突破,不过算法驱动的智能程度严重依赖海量的样本数据和高性能的计算能力。当下,在提升AI数据处理的效率方面,存储和计算领域已经发生革命性的变化。

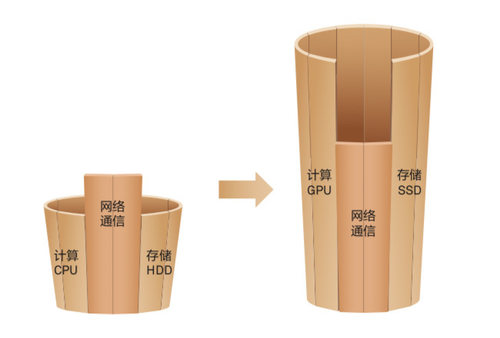

存储介质从机械硬盘(HDD)演进到闪存盘(SSD),来满足数据的实时存取要求,介质时延降低了不止100倍;在算力方面,业界已经在采用GPU甚至专用的AI芯片,处理数据的能力提升了100倍以上。

不过虽然存储介质和计算能力在大幅提升,但当前网络通信时延却成为性能进一步提升的瓶颈。通信时延在整个存储E2E时延中占比从10%跃迁到60%以上,也就是说,宝贵的存储介质有一半以上的时间是空闲通信等待;计算瓶颈也类似,如某语音识别训练,每次迭代任务时长为650ms~700ms,通信时延为400ms, 同样,昂贵的处理器也有一半时间在等待模型参数的通信同步。

所以回到上面那个问题,在推动AI发展起到关键支撑作用的底层网络基础设施是否已经准备好?答案是Yes也是No。

(图)网络通信成为系统性能的短木板

RDMA的变迁和AI网络的新诉求

可能有的人对这个结论产生疑问,他们会说RDMA(Remote Direct Memory Access,即远程直接数据存取)已大大降低了通信时延。的确,RDMA在AI运算和SSD分布式存储追求极致性能的网络大潮中,替换TCP/IP已是趋势。目前,国内外不少互联网公司已经开始部署RDMA,甚至大规模部署,例如微软等企业。

因为RDMA的内核旁路机制,允许应用与网卡之间的直接数据读写,将服务器内 的数据传输时延降低到接近1us(微秒)。同时,RDMA的内存零拷贝机制,允许接收端直接从发送端的内存读取数据,极大地减少了CPU的负担,提升CPU效率。

但RDMA并不完美,专用InfiniBand和传统以太网络是RDMA的两类网络承载方案。具体说来:

InfiniBand是一个用于高性能计算的计算机网络通信标准,不同于传统 TCP/IP协议栈,Infiniband拥有自己的网络层和传输层协议。而绝大多数现网都采用IP以太网络,所以对于需要广泛互联的AI计算和分布式存储系统,采用InfiniBand无法满足互通性需求。并且,作为专用的网络技术,Infiniband无法继承用户在IP网络上运维的积累和平台。

对于基于传统的IP以太网络来承载RDMA方案来说,其缺乏完善的丢包保护机制,>10-3的丢包率,将导致RDMA有效吞吐急剧下降。很多厂家会采用PFC和ECN机制来避免丢包提升吞吐率,而现有的RDMA拥塞&调度算法,导致网络设备极易出现队列累积,从而触发PFC。网络中如果出现大量PFC,极有可能诱发网络死锁,导致网络系统性风险。

所以,RDMA的高效运行,离不开一个0丢包、高吞吐的开放以太网作为承载。并且,在由应用架构从集中式走向分布式架构过程中造成的incast突发流量和“大包”特征,也进一步加剧了网络拥塞。

总之,无论是应用分布式架构,还是RDMA通信效率的角度,均呼吁数据中心网络发生变革。近日,华为发布了《AI Fabric, 面向AI时代的智能无损数据中心网络》白皮书(以下简称“白皮书”),白皮书指出,这场AI驱动的网络变革需要更智能的调度和无损的转发,实现零丢包、低时延、高吞吐的智能无损数据中心网络。

AI Fabric打造面向AI时代的智能无损网络

在HUAWEI CONNECT 2018上,华为正式发布了AI Fabric智能无损数据中心网络方案。“0丢包”,“低时延”和“高吞吐”即是AI Fabric的三个核心特征,这背后源自于华为创新的iLossless AI算法技术,提供独特的精确拥塞流识别、动态拥塞水线设定和快速反压机制等系列拥塞管理和流量控制能力,从而带来极致网络性能。

白皮书指出,面对动态流量和海量参数挑战,华为一方面投入研究团队分析各种应用,提炼出流量模型特征;另一方面通过在交换机集成AI芯片,实时采集流量特征和网络状态,基于AI算法,本地实时决策并动态调整网络参数配置,使得交换机缓存被合理高效利用,实现整网0丢包。

AI Fabric带来的卓越性能进一步也提升了其所带来收益:45倍的ROI(投资回报率)。怎么得出来的?

据权威第三方测试机构ENTAC测试结论,AI Fabric可以在HPC场景下最高降低44.3%的计算时延,在分布式存储场景下提升25%的IOPS能力。从商业价值角度看,25%的IOPS性能提升相当于同性能下存储投资减少25%。以512个节点组成的分布式存储系统为例,采用AI Fabric意味着384个存储节点即可获得采用传统网络512个存储节点的IOPS性能。综合测算,存储CAPEX降低的收益与AI Fabric的投资相比,至少可带来45倍的ROI收益率。

并且同样重要的是,基于标准的以太网架构,华为AI Fabric带来了一张统一融合的网络。一张网可承载LAN(局域网)、SAN(存储区域网络)和IPC(进程间通信)三种流量,避免了专网独立维护。

一般说来,当前的数据中心内部有三张不同的网络: Infiniband网络提供低时延的网络IPC通信,FC网络提供高可靠0丢包的存储网络,而传统的以太网承载一般的业务。显然,这样当前数据中心网络整体成本很高。AI Fabric同 时承载SAN和IPC流量和一般LAN流量,成为AI时代的数据中心构建统一融合网络架构的最佳选择。

在产品端,华为则提供了AI Ready的交换机硬件架构,支撑AI Fabric长期演进。AI Fabric通过内嵌AI智能芯片的CloudEngine交换机,基于CLOS组网模型构建Spine-Leaf两级智能架构:计算智能和网络智能结合,全局智能和本地智能协同。

在核心层设备智能方面,华为将于2019年1月9日发布内嵌AI芯片的下一代智能数据中心交换机,从而为AI Fabric的未来智能演进提供硬件架构保证。

AI Fabric的实践和未来

当然,华为打造的AI Fabric智能无损数据中心网络方案并不是一套理论方案,它已经得到检验和实践。就像上文所说,AI Fabric经过了EANTC的严格测试验证,在高性能计算和分布式存储的所有场景测试用例中,都实现了高吞吐和零丢包,并基于网络时延的优化有效缩短高达40%的HPC节点间通信时长,大幅提升AI训练等创新业务效率。在今年的东京Interop展上,华为AI Fabric还荣获了官方发布的Best of Show Award金奖。

目前,AI Fabric已经在互联网和金融行业得到应用。

某互联网巨头布局无人驾驶,但因涉及到大量的AI计算(1天采集的数据,需要几百的GPU服务器7天才能训练完),严重影响无人驾驶的上市时间。通过华为AI Fabric提供0丢包、低时延、高吞吐的极速无损以太网络,最终使得整体训练的时长缩短40%。

在招商银行,AI Fabric智能拥塞调度加速网络通信,经实测最终存储集群IOPS性能提升了20%,单卷性能达到35万IOPS。加速了招商银行分行云性能,为用户提供了像访问本地盘一样的使用体验。

总之来说,AI正在走进越来越多的企业,就像华为GIV(Global Industry Vision)所预测:到2025年企业对AI的采用率将达到86%,越来越多的企业将AI视为数字化转型的下一站。

在这一转型进程中,数据中心网络亟需消除自身短板,从而转向更高吞吐、更低时延、更可靠、稳定和融合的链路技术和网络协议。AI Fabric智能无损数据中心网络无疑为市场提供了一个面向AI时代的极佳选择。

编辑:NIKI

“到2020年,行业前15%的企业都将采用机器学习;到2023年,人工智能将取代50%的IT业务工作量”。

杂志订阅

杂志订阅 编辑

编辑 网管

网管 培训班

培训班 市场部

市场部 发行部

发行部 010-82024981

010-82024981